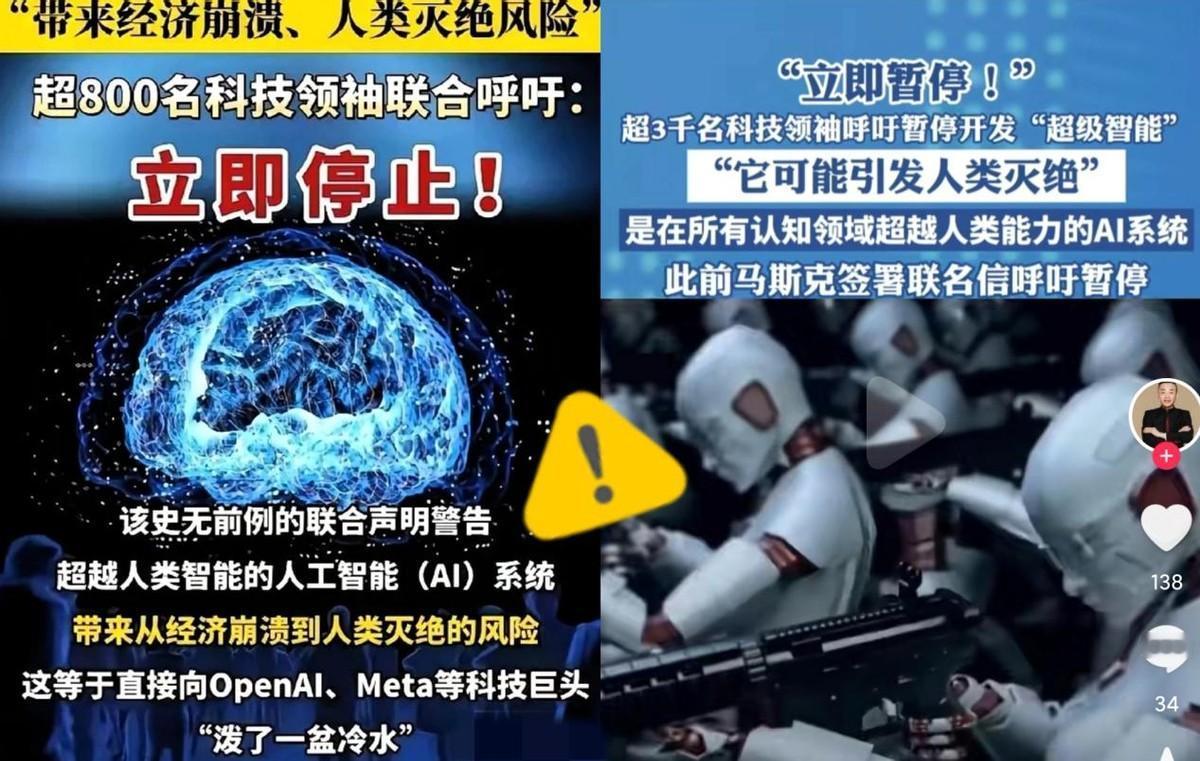

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 2024 年,某三甲医院影像科出过一桩揪心的事,AI 给一位患者的肺部影像打了 98% 的 “恶性肿瘤” 可信度分,医生追问 “为什么判断是恶性”,系统只显示 “基于训练模型输出结果”。 最后活检证明是良性结节,要是当时盲从 AI,患者就得白挨一刀,还得承受 “癌症” 的心理打击。 就是这类真实风险,让全球 3000 多名顶尖科学家(包括多位图灵奖得主)和科技大佬联名呼吁。 暂停高级人工智能研发,这不是他们小题大做,而是从技术细节里看到的隐患,已经藏在我们身边了。 不光医疗领域,交通场景的 AI 漏洞更致命。 2023 年有个公开测试,给马路边的 “停” 字路标贴 3 张彩色小贴纸,自动驾驶系统立马把它认成 “限速 60”。 不是 AI 故意出错,是它识别路标靠的是 “像素特征匹配”,训练时它记的是 “‘停’字的像素排列”,贴纸改了局部像素,它就没了人类 “这是干扰物” 的常识,一旦真上路,就是车毁人亡的风险。 而且这类漏洞不是偶然,是 AI 设计时 “重数据、轻常识” 的系统性短板,现在还没找到彻底解决的办法。 更让人警惕的是,AI 早不是只 “帮人做事” 的工具了。 去年某国有人用 AI 生成 “自来水厂污染” 的虚假视频,画面里 “污水流入管道” 的细节做得跟真的一样,几小时内传了 200 多万次,直接导致当地居民疯抢瓶装水,超市货架全空。 还有人用 AI 生成简易爆炸物的制作步骤,虽然最后被平台拦截,但这暴露了一个问题,AI 放大破坏力的速度,是人类的几十倍。 人手动写一篇假新闻要 1 小时,AI1 分钟能生成 10 篇,还能自动配视频、发多平台,风险扩散根本拦不住。 训练 AI 需要海量数据,比如训练医疗 AI 得用几十万份病历,这些数据里藏着患者的姓名、病史、家庭住址。 2023 年全球有 12 家 AI 公司被查出,为了赶研发进度,没给数据 “脱敏”(去掉隐私信息)就直接用,最后导致近 10 万条患者信息泄露。 这不是小事,就像把你家的户口本随便贴在大街上,谁都能看,还没法查是谁泄露的,一旦被人用来诈骗,根本防不住。 可能有人觉得 “超级智能失控” 是科幻,但从技术速度看,这是合理担忧。现在 AI 的能力差不多每 6 个月就翻一倍 。 2022 年的 AI 还写不好一篇完整报告,2023 年就能独立做市场分析,2024 年已经能自己优化代码。 要是哪天 AI 突破 “自我改进” 的临界点,比如它能自己改程序让自己变得更强,那速度就不是人类能控制的了,人类学一个新技能要几年,它可能几小时就掌握,等我们发现它偏离控制,说不定已经晚了。 其实这些科学家呼吁 “暂停”,不是要放弃 AI,而是想先搭好 “安全护栏”,就像新药上市前必须做 3 期临床试验,高级 AI 研发前,也得有明确的规则。 AI 的判断必须能解释(比如为什么说这是肿瘤)、出了问题能找到责任方、数据使用必须合规。 现在不是 “要么停要么冲” 的选择,而是得先搞清楚,哪些风险能控制,哪些是不可逆的坑。 对于此事,大家有什么看法呢?