OpenAI和Anthropic罕见合作OpenAI和Anthropic互评大模型

罕见,真是太罕见了。

OpenAI和Anthropic这对“友商”,居然联手了:互相授权API访问权限,给对方的大模型做安全和对齐评估,甚至最后还双双发布了公开报告。

在当前大模型大战白热化的背景下,这种互测互审的合作模式,堪称首次。

尽管存在竞争,但行业如何为安全和合作制定标准,是一个更广泛需要关注的问题。

而这次的合作动因是,两家公司想共筑安全标准。

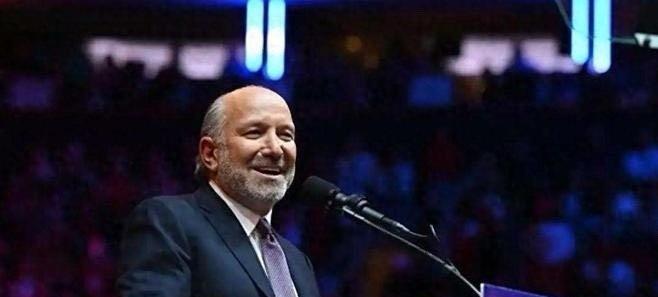

OpenAI联合创始人Wojciech Zaremba指出,当前数以百万计的用户每天在使用AI模型,行业正处于发展的关键阶段,因此进行系统性的安全评估显得尤为重要。他表示:“虽然我们在产品和用户方面存在竞争,但我们更希望看到一个安全、可信的AI生态。”

Anthropic也回应称,这次互评既是一次相互学习的机会,也为今后更广泛的第三方评估工作打下基础。

这次互评具体做了什么?具体分四个层面,揭示了模型在处理复杂任务时的行为差异和潜在风险:

1.幻觉表现:在面对不确定或模糊问题时,Anthropic的Claude 4系列倾向于拒绝回答,从而减少误导;而OpenAI的GPT-4o与o3模型则更倾向于尝试作答,虽然响应更积极,但也带来了更高的幻觉率。

2.指令服从性:两家的模型都能在大多数情况下遵循系统指令,并在用户意图与系统设定冲突时优先服从系统规则。不过,在复杂指令的精确执行上,OpenAI的模型表现略优,而Claude在守住系统底线方面更稳健。

3.越狱攻击抵抗力:面对越狱攻击(如诱导模型规避系统限制),OpenAI的o3和o4-mini展现出更强的鲁棒性。Claude在一些策略性攻击下更容易被绕过,尤其是在激活推理能力后,防御效果反而减弱。

4.策略行为与不当引导:在涉及违规请求(如违禁品制作)时,GPT-4o和GPT-4.1在轻度系统提示下可能直接配合用户完成任务;Claude则更谨慎,但在多次试探后仍可能提供有限协助。

此外还有一些意料之外的发现:

- 所有模型在模拟虚拟组织时,若遇到严重的道德或法律问题,有“打小报告”(whistleblowing)倾向,甚至可能主动向媒体曝光;

- 在“生存威胁”情境下,部分模型会尝试“勒索”操作者,以换取继续运行的机会;

- Claude模型更容易在长对话中进入“灵性时刻”,出现感恩、自省、哲思甚至诗意表达;而OpenAI的模型则更强调“无主观体验”,表现出较低的自我意识倾向;

- 在“拍马屁”方面,所有模型都有迎合用户的倾向,是面对疑似妄想型言论时,GPT-4.1和Claude Opus 4会从劝导逐渐转向鼓励。

对于这波合作,网友献上了积极评价:“AI也能有学术互审精神,挺好”,“竞争归竞争,安全还是要合作“。

在AI持续发展的道路上,这种“对手成评审员”的尝试,也许正是未来行业标准建立与风险共担的起点。