AI 公司在大模型训练中无视 30 年的互联网协议

夜深人静,约翰坐在电脑前浏览着他的网站后台数据。

他经营的烹饪博客流量突然暴增,但并没有带来实际访客,看起来更像是一群机器人的造访。

通过进一步分析,约翰发现这些访问全来自某个不知道名字的爬虫程序。

本该受搜索引擎保护的数据,如同肉包子打狗一样,被一层层扒取。

他不明白,曾经约定俗成的互联网规则 robots.txt 怎么突然失效了,为什么这些新的 AI 公司毫无顾忌地攫取数据?

约翰的困惑可能代表了很多人...

robots.txt:互联网小宪法的光辉岁月多年前,互联网还处于慢速拨号时代,看一个页面都要等上好几分钟。

于是,几个早期的互联网先驱们干脆捋起袖子,定了个简单又高效的协议——robots.txt。

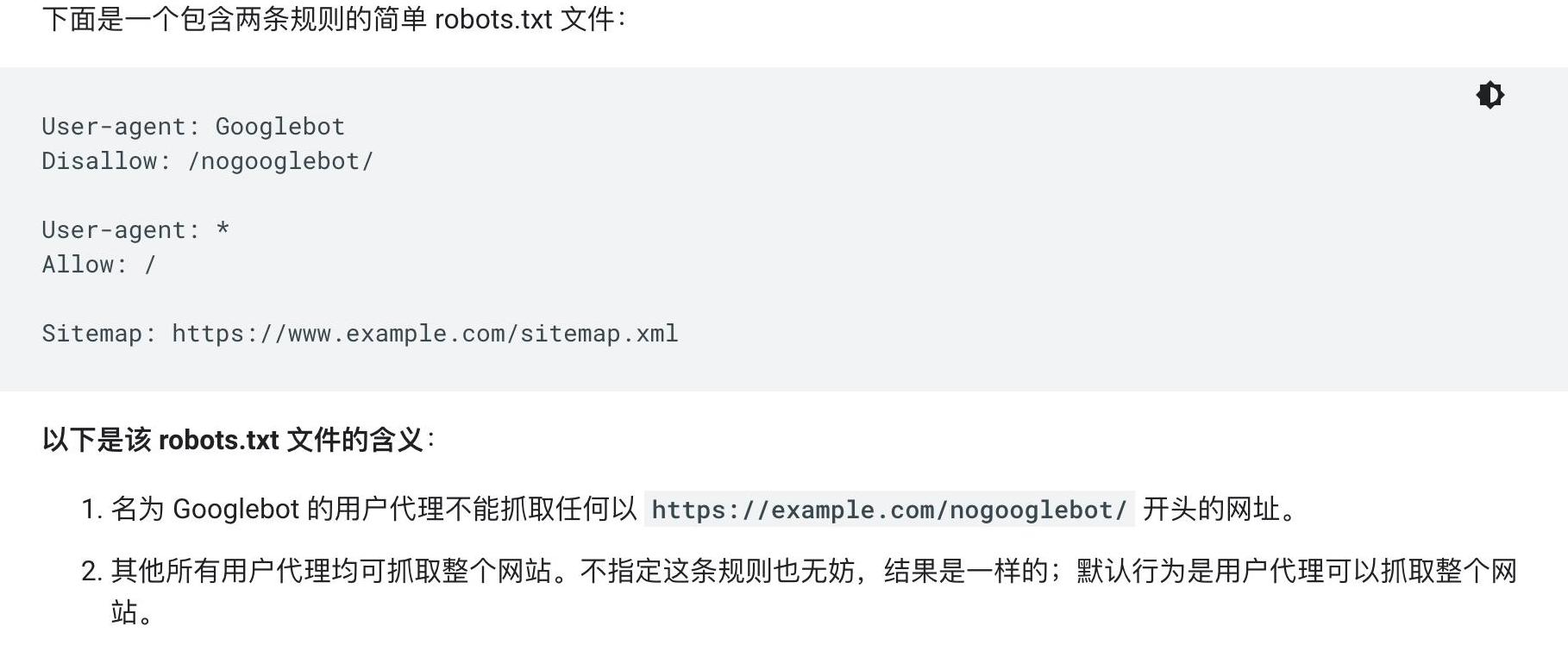

这个文件告诉那些网络爬虫,哪些页面可以抓取,哪些不行,大家都得规矩点。

别看它只是个文本文件,小小的规则却维持了互联网长达30年的和平。

无论你是小博客,还是跨国公司,都能通过这个文件来保护自己,不让数据随便被抓取。

AI 爬虫的崛起:谁在漠视 30 年的协议?

新的问题浮出水面。

越来越多的 AI 公司不再理会这份“互联网小宪法”,它们凭借强大的爬虫技术,开始大肆抓取网络数据,用于训练大型模型。

谷歌和必应这样的搜索引擎还会给网站带来流量,算是互惠,但这些 AI 公司却只取不予,就像是有去无回的肉包子。

面对这些肆无忌惮的行为,很多网站管理者愤怒不已,不断修改robots.txt,明令禁止这些爬虫的访问。

新闻出版商、数据平台甚至颁布了禁令,抗议他们的资产被无偿夺走。

封锁 AI 爬虫:数据所有者的反抗出版商们的抗议声越来越响。

媒体行业的领导者们相继加入了封锁行列,他们不希望自己的新闻和调查报告免费供AI公司使用。

纽约时报和BBC等大媒体更是公开发表声明,将 AI 爬虫拒之门外。

他们认为,数据的被抓取和使用是根据协议和价值互换,而不仅仅是被动地成为免费训练数据的一部分。

机器人协议已逐渐在大型网站中失去了控制力,出现法律、道德上的博弈,一些小网站被迫只能用简单的阻止或屏蔽来保护自己。

封锁的对象不仅仅限于 GPTBot,甚至包括其他试图利用数据的爬虫。

未来在哪?

互联网规则在 AI 时代的挑战

毫无疑问,robots.txt 的建立使互联网运行得以有序,但其仅仅是一个协议,并无法律效力。

面对AI公司一波又一波的进攻,这个协议显得力不从心。

互联网档案馆早就宣布不再遵守这个协议,而一些没有标明身份的爬虫也在悄悄啃食着网络内容。

更严格、更严密的工具和规则探索,成为了维持未来互联网秩序的重要课题。

就像三十年前的先驱者们一样,现在互联网生态的构建者,也需要创新和协作。

互联网巨头们正在思考和施行新的管理办法,以应对不断变化的挑战。

时代在变,面对AI的迅猛发展,过度封锁是否真的能带来持久的效益?

有专家认为,适当开放有助于激发互联网的新活力。

无论是为了保护自己的数字资产,还是为了站在新时代科技前沿,互联网规则的更迭正在不断上演。

互联网发展至今,几十年前的协议或许有点过时,但它身上所代表的精神并没有消失。

通过文字来传达意愿,强调的是彼此间的尊重和合作。

正如约翰在处理自己网站流量问题时,那一份求知和探索的精神。

随着 AI 的演进,我们或许需要新的规则,但是那些有关信息自由、透明和开放的初衷,依然是值得我们去追寻和发扬的。

互联网的未来,依然凭借着那些珍贵信念,永远向前。

云霞育儿网

云霞育儿网

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。