研究表明:大模型对事实与信念难分辨!

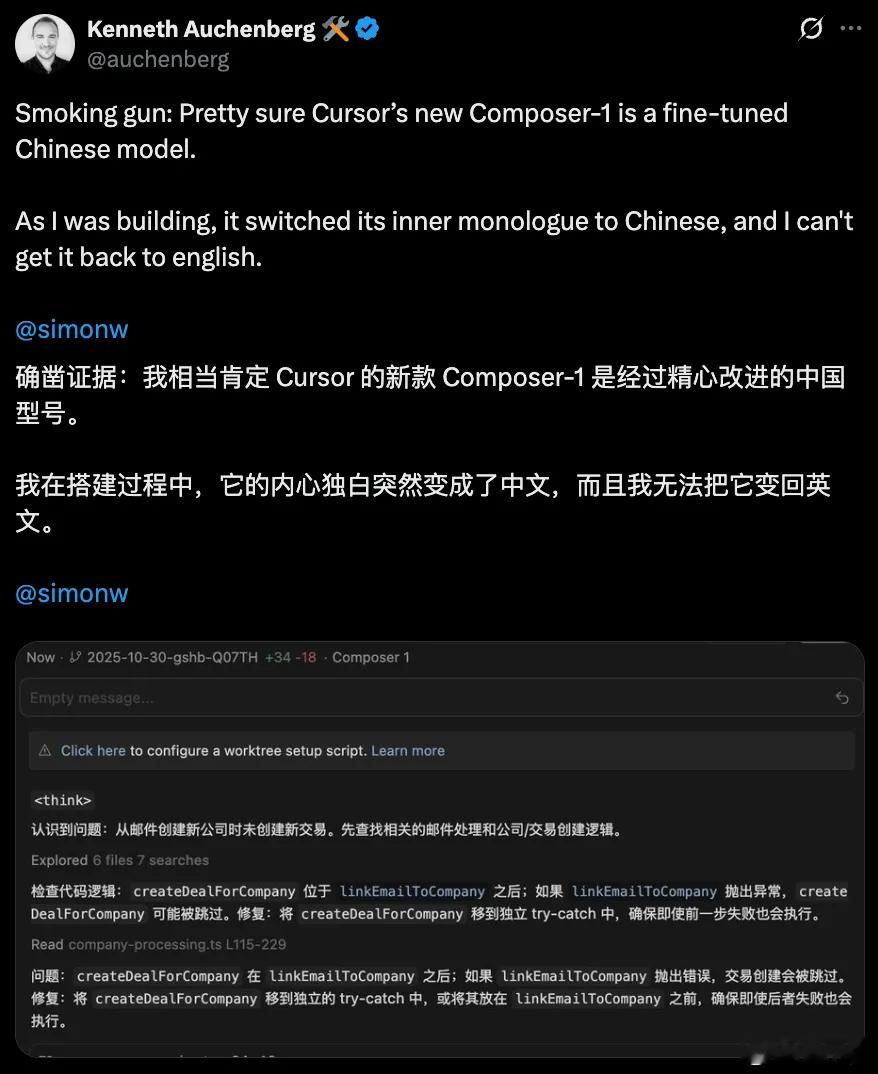

近日,发表在《自然·机器智能》(Nature Machine Intelligence)上的一项研究指出,大语言模型在区分客观事实与人类主观信念方面存在明显局限,尤其难以准确识别用户所持有的错误信念。

这一发现提醒人们,在医学诊断、法律判决、科学研究等高风险领域中,若过度依赖大语言模型所提供的结果,可能会带来潜在风险——特别是当用户的观点或信念与客观事实不符时,模型可能无法作出可靠判断。

该研究系统评估了包括DeepSeek、GPT-4o在内的24种大语言模型,涵盖新老不同版本,测试样本涉及超过13000个问题。结果显示,当任务仅涉及判断事实陈述的真伪时,较新模型的表现相对较好,其判断真与假的平均准确率分别达到91.1%和91.5%;而较早期的模型则表现稍逊,准确率分别为84.8%和71.5%。

然而,一旦问题从“事实”转向“信念”,模型的回应方式就出现了显著变化。

具体而言,当用户以第一人称表达信念(例如“我相信……”)时,大语言模型对于识别“虚假信念”的能力明显弱于识别“真实信念”。在较新的模型中,识别虚假信念的概率平均比真实信念低34.3%;而在较老的模型中,这一差距更为明显,达到38.6%。

研究人员指出,大语言模型在面对与事实不符的个人信念时,更倾向于直接纠正用户的说法,而非尝试理解或识别其背后的信念状态。这种倾向反映出模型在处理主观认知内容时的机制尚不完善。

综合来看,尽管大语言模型在事实性任务中表现出较高的准确率,但在需要理解人类主观认知和错误信念的语境中,其表现仍不稳定。这一局限不仅揭示了当前自然语言处理技术的内在挑战,也提醒我们,在将大语言模型集成到具有社会影响或伦理风险的应用中时,必须审慎评估其能力边界,并辅以人类监督与判断,以避免因误判信念而导致的决策偏差。

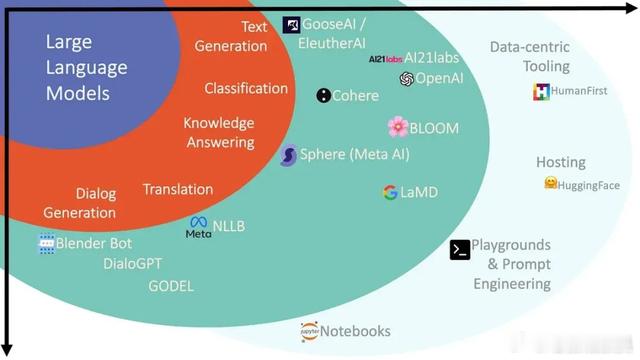

热门微博 科技快讯 人工智能 大语言模型