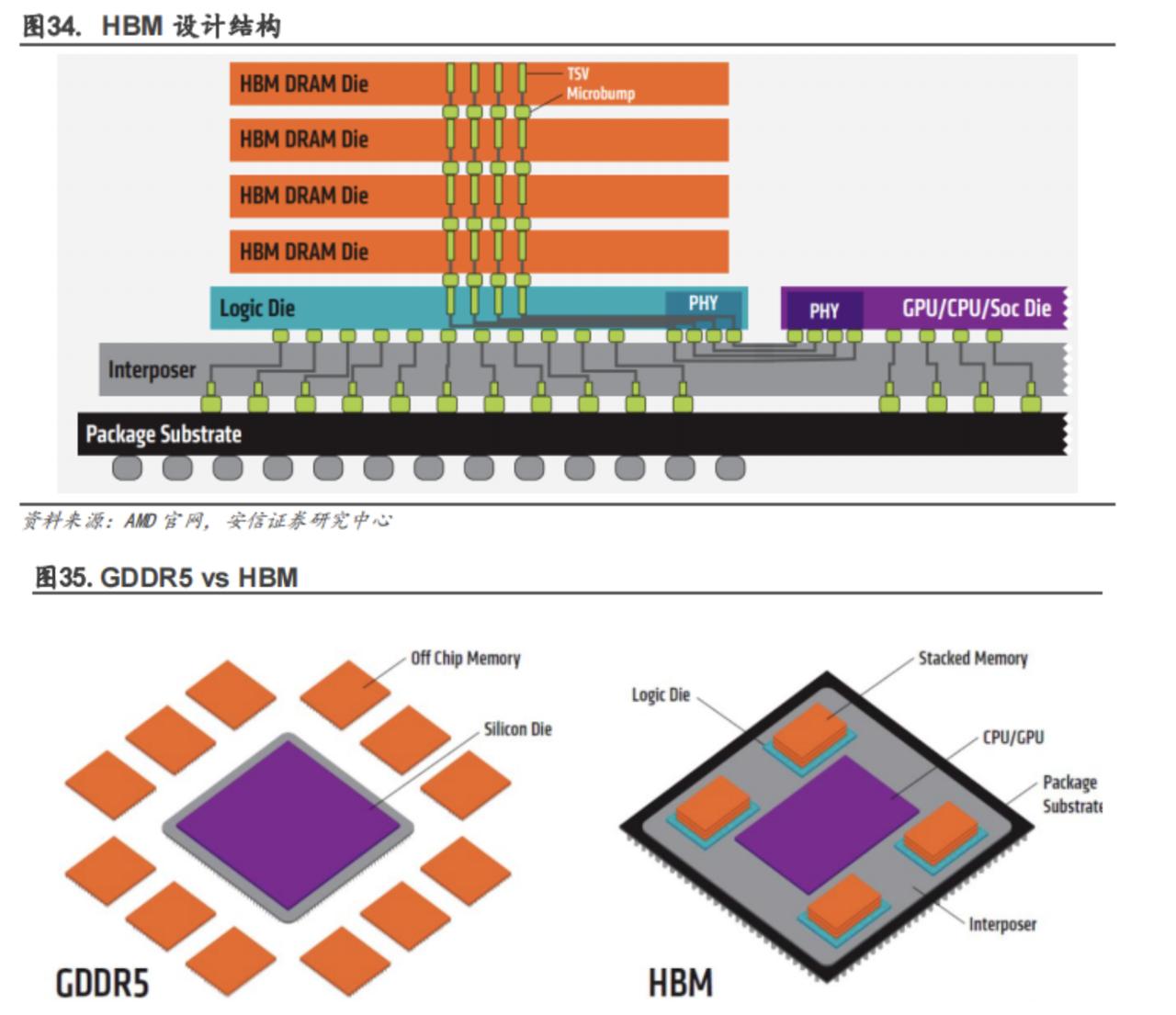

市场热点概念科普:Chiplet、HBM、CXL 一、Chiplet:像拼乐高一样造芯片 1.1 背景 传统芯片的设计思路是“单芯片集成”,即所有功能(CPU、GPU、缓存、接口等)都集成在一块大硅片上。但随着工艺节点的缩小,单芯片面积越来越大,良率下降,成本高企。 1.2 什么是 Chiplet? Chiplet 就是把一个复杂芯片拆分成多个小芯粒(小芯片),然后通过 先进封装 技术把它们拼接在一起,就像拼乐高。 CPU 芯粒:负责逻辑计算 GPU 芯粒:负责图形或 AI 计算 IO 芯粒:负责输入输出 缓存芯粒:提升数据访问速度 这样做的好处是: 提升良率:小芯片更容易制造成功。 降低成本:坏片率减少,整体成本下降。 灵活组合:可以用不同工艺节点的芯粒拼接,比如先进工艺做 CPU,成熟工艺做 IO。 1.3 应用与趋势 AMD 已在其服务器 CPU 上全面采用 Chiplet 架构,英特尔和其他公司也在跟进。未来 AI 芯片、数据中心芯片几乎都会采用这种方式。 二、HBM:为 AI 提供“高铁”内存 2.1 背景 随着 AI 模型参数量暴增,对显存容量和带宽的需求越来越高。传统显存(GDDR6 等)在带宽和能效上逐渐跟不上。 2.2 什么是 HBM? HBM,全称 High Bandwidth Memory(高带宽内存),是一种堆叠式内存。它通过 3D 封装 + TSV(硅通孔)技术 把多层 DRAM 芯片垂直堆叠,再通过宽位宽接口与 GPU/AI 加速器相连。 特点: 带宽极高:单颗 HBM 带宽可达数百 GB/s,是传统显存的数倍。 功耗更低:相比传统显存,传输相同数据功耗更低。 体积更小:垂直堆叠节省空间。 2.3 应用与趋势 HBM 已成为 AI 训练服务器的标配。NVIDIA、AMD、Intel 的高端 AI 芯片都采用 HBM,国内厂商也在追赶。未来 HBM 会持续迭代到 HBM4、HBM4E,带宽和容量进一步提升。 三、CXL:数据中心的“共享内存高速公路” 3.1 背景 传统服务器架构中,CPU、GPU、加速器各自有独立内存,导致: 数据搬运开销大 资源利用率低 成本浪费 3.2 什么是 CXL? CXL,全称 Compute Express Link(计算快速互联),是一种基于 PCIe 的高速互联协议。它的核心价值是让 CPU、GPU、AI 加速器等共享内存资源,实现更高效的数据访问。 特点: 内存共享:不同处理器可直接访问对方内存。 低延迟:相比传统 PCIe 通信,延迟更低。 灵活扩展:可以外接内存池,多个 CPU/GPU 共享使用。 3.3 应用与趋势 CXL 已被 Intel、AMD、NVIDIA、三星、美光等公司支持,并成立了产业联盟。未来数据中心会大量部署 CXL 技术,提升资源利用率,降低 AI 训练和大规模计算的内存成本。 四、总结:三者的关系 Chiplet:解决“芯片制造难度与成本”问题,让设计更灵活。 HBM:解决“AI 内存带宽与容量”问题,为算力提供高速燃料。 CXL:解决“数据中心资源利用率”问题,让算力更高效协作。 可以把它们类比: Chiplet 是“造车新方法”,让零件更灵活。 HBM 是“高铁燃料”,让引擎更快。 CXL 是“高速公路网络”,让所有车共享道路和加油站。 这三大技术正共同推动算力体系走向更高性能、更低功耗、更灵活的未来。