近期,张江AI小镇入驻企业——上海蚂蚁灵波科技有限公司(下称“蚂蚁灵波”)近期迎来了一波开源浪潮。公司连续4天先后宣布,正式开源LingBot-Depth空间感知模型、LingBot-VLA具身大模型、世界模型LingBot-World、具身世界模型LingBot-VA,为推动具身智能发展提供了重要的技术基础设施。

2025年,我们频频看到各种惊艳的机器人Demo:机器人叠衣服、做咖啡、跳各种舞,显示出日益灵巧的操作能力。

进入2026年,机器人进一步走向大众视野,目前已有三家具身智能相关企业先后官宣,成为今年春晚的合作伙伴。

然而,在机器人真正融入现实应用的过程中,仍面临着具身智能模型泛化能力与部署效率的双重挑战。真正的“具身智能”,应是能够全面自主决策与行动的通用机器人,其基础在于对物理世界的深入理解。

作为张江AI小镇人工智能产业生态的重要一员,蚂蚁灵波的这一重磅成果落地,不仅是小镇创新活力的生动体现,更成为具身智能行业技术开源的重要标杆,为行业突破核心技术瓶颈提供了关键的开源技术支撑。

据规划,张江人工智能创新小镇到2027年,集聚人工智能垂类大模型应用企业超800家,培育行业标杆企业3至5家,完成超100个大模型备案,打造超30个人工智能示范应用场景,人工智能产业规模达650亿元。到2030年,实现集聚人工智能垂类大模型应用企业超1000家、产业规模超1000亿元的“双千”目标,形成一批具有复制推广意义的标杆应用场景。建成充满活力的创新小镇、产城融合的品质小镇、智慧生态的未来小镇,成为全球人工智能创新创业人才的首选地。

在这样的沃土滋养下,蚂蚁灵波的多款模型有多强?

01

LingBot-Depth正式开源:让机器人“看清”物理世界

不同于数字世界,具身智能的落地高度依赖物理空间信息,空间智能是其在现实场景落地应用的核心关键,而视觉维度下支撑空间智能的重要桥梁正是距离与尺度(Metric Depth)。基于这一核心需求,空间感知模型LingBot-Depth应运而生。

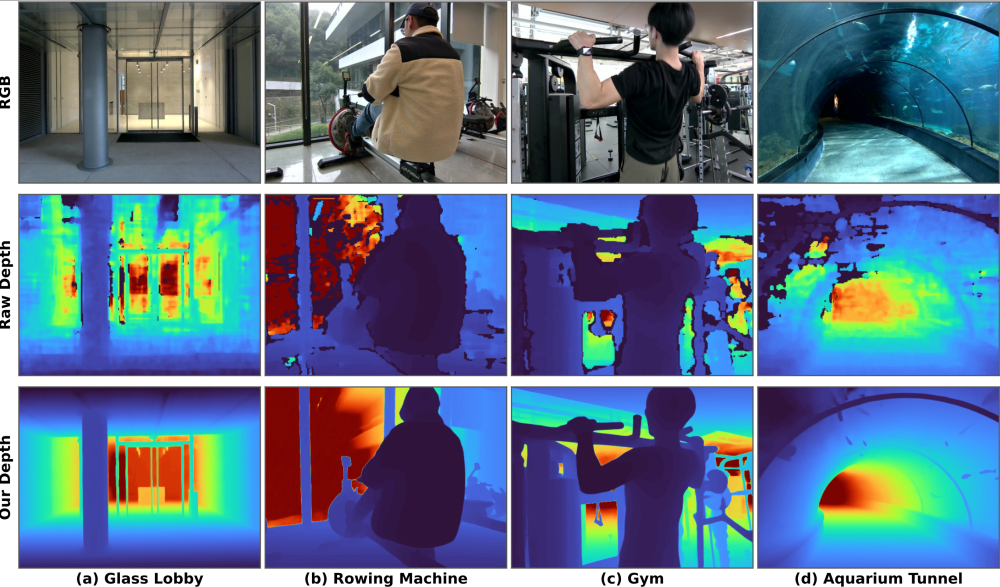

LingBot-Depth是一种面向真实场景的深度补全模型,依托奥比中光Gemini330系列双目3D相机进行RGB-Depth数据采集与效果验证,并基于深度引擎芯片直出的深度数据进行训练与优化,旨在将不完整且受噪声干扰的深度传感器数据转化为高质量、具备真实尺度的三维测量结果,提升环境深度感知与三维空间理解能力,为机器人、自动驾驶汽车等智能终端赋予更精准、更可靠的三维视觉。

实验结果表明,本模型在深度精度与像素覆盖率两项核心指标上均超越业界顶级工业级深度相机。在NYUv2、ETH3D等多个基准测试中,LingBot-Depth在深度补全、单目深度估计及双目匹配任务上均达到当前最优水平,并在无需显式时序建模的情况下保持视频级时间一致性。LingBot-Depth模型也已通过奥比中光深度视觉实验室的专业认证,在精度、稳定性及复杂场景适应性方面均达到行业领先水平。

下游任务验证进一步表明,模型能够在RGB与深度两种模态之间学习到对齐的潜在空间表征,从而实现对透明及反光物体的稳定机器人抓取。

目前,蚂蚁灵波科技已与奥比中光达成战略合作伙伴关系,将基于LingBot-Depth模型推出新一代深度相机,依托Gemini330系列相机提供的芯片级3D数据,进一步通过技术协同、生态共建,为机器人处理各行各业极端场景、走向真正落地提供强大的技术支撑。

LingBot-Depth已成功实现模型轻量化与端侧部署,具备在边缘计算设备上高效运行的能力。

02

LingBot-VLA具身大模型全面开源,积极探索具身智能上限

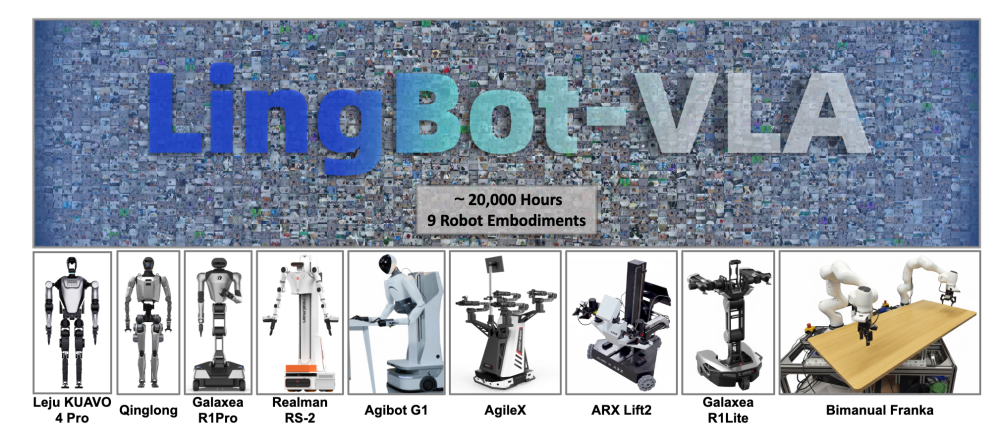

作为一款面向真实机器人操作场景的“智能基座”,LingBot-VLA实现了跨本体、跨任务泛化能力,并大幅降低后训练成本。

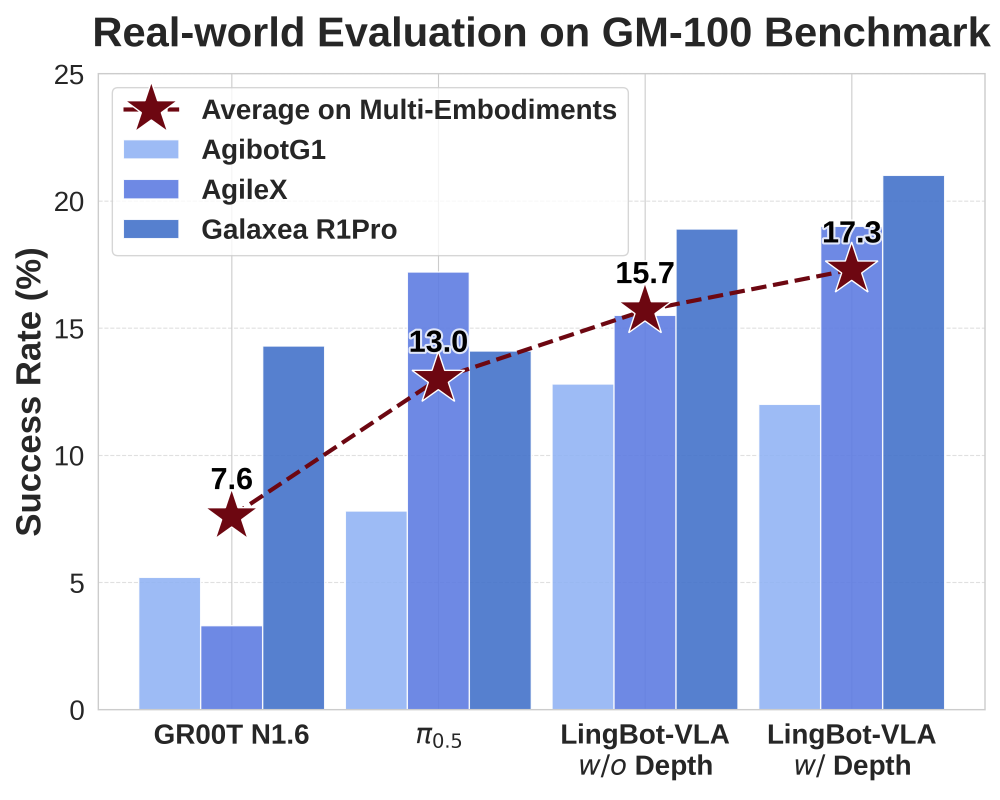

在上海交通大学开源的具身评测基准GM-100(包含100项真实操作任务)测试中,LingBot-VLA在3个不同的真实机器人平台上,跨本体泛化平均成功率相较于Pi0.5的13.0%提升至15.7%(w/o Depth)。引入深度信息(w/ Depth)后,空间感知能力增强,平均成功率进一步攀升至17.3%,刷新了真机评测的成功率纪录,验证了其在真实场景中的性能优势。

在RoboTwin2.0仿真基准(包含50项任务)评测中,面对高强度的环境随机化干扰(如光照、杂物、高度扰动),LingBot-VLA凭借独特的可学习查询对齐机制,高度融合深度信息,操作成功率比Pi0.5提升了9.92%,实现了从虚拟仿真到真实落地的全方位性能领跑。

长期以来,由于本体差异、任务差异、环境差异等,具身智能模型落地面临严重的泛化性挑战。开发者往往需要针对不同硬件和不同任务重复采集大量数据进行后训练,直接抬高了落地成本,也使行业难以形成可规模化复制的交付路径。

针对上述问题,LingBot-VLA基于20000+小时大规模真机数据进行预训练,覆盖了9种主流双臂机器人构型(包括AgileX,GalaxeaR1Pro、R1Lite、AgiBot G1等),从而让同一个“大脑”可以快速迁移至不同形态的机器人上,并在任务变化、环境变化时保持可用的成功率与鲁棒性。与高精度空间感知模型LingBot-Depth配合,LingBot-VLA能获得更高质量的深度信息表征,通过“视力”的升级,真正做到“看得更清楚、做得更明白”。

LingBot-VLA凭借扎实的基座能力,大幅降低了下游任务的适配门槛,仅需80条演示数据即可实现高质量的任务迁移。此外,配合底层代码库的深度优化,其训练效率达到StarVLA、OpenPI等主流框架的1.5~2.8倍,实现了数据与算力成本的双重降低。

此次开源不仅提供了模型权重,还同步开放了包含数据处理、高效微调及自动化评估在内的全套代码库。这一举措大幅压缩了模型训练周期,降低了商业化落地的算力与时间门槛,助力开发者以更低成本快速适配自有场景,模型实用性大幅提升。

03

世界模型LingBot-World正式开源,助力提升具身智能算法在真实场景中的泛化能力

LingBot-World是一个专为交互式世界模型设计的开源框架。其核心LingBot-World-Base致力于提供高保真、可控制且逻辑一致的模拟环境。该模型由一个可扩展数据引擎(Scalable Data Engine)驱动,通过从大规模游戏环境中学习物理规律与因果关系,实现了与生成世界的实时交互。

在视频质量、动态程度、长时序一致性与交互能力等关键指标上,LingBot-World均展现出业界领先的性能,为具身智能、自动驾驶及游戏开发领域,提供一个高保真、高动态、可实时操控的“数字演练场”。

LingBot-World的设计初衷,是为了打造这样一个足够真实、可交互、可泛化的“数字演练场”。为此,蚂蚁灵波科技围绕“长时序一致性与记忆能力、高保真实时交互、Zero-shot泛化与混合数据策略”等核心技术方向进行了深入探索。

04

世界模型走入物理世界,蚂蚁灵波开源LingBot-VA,让机器人“先思后行”

LingBot-VA首次提出自回归视频-动作世界建模框架,将大规模视频生成模型与机器人控制深度融合,模型在生成“下一步世界状态”的同时,直接推演并输出对应的动作序列,使机器人能够像人一样“边推演、边行动”。

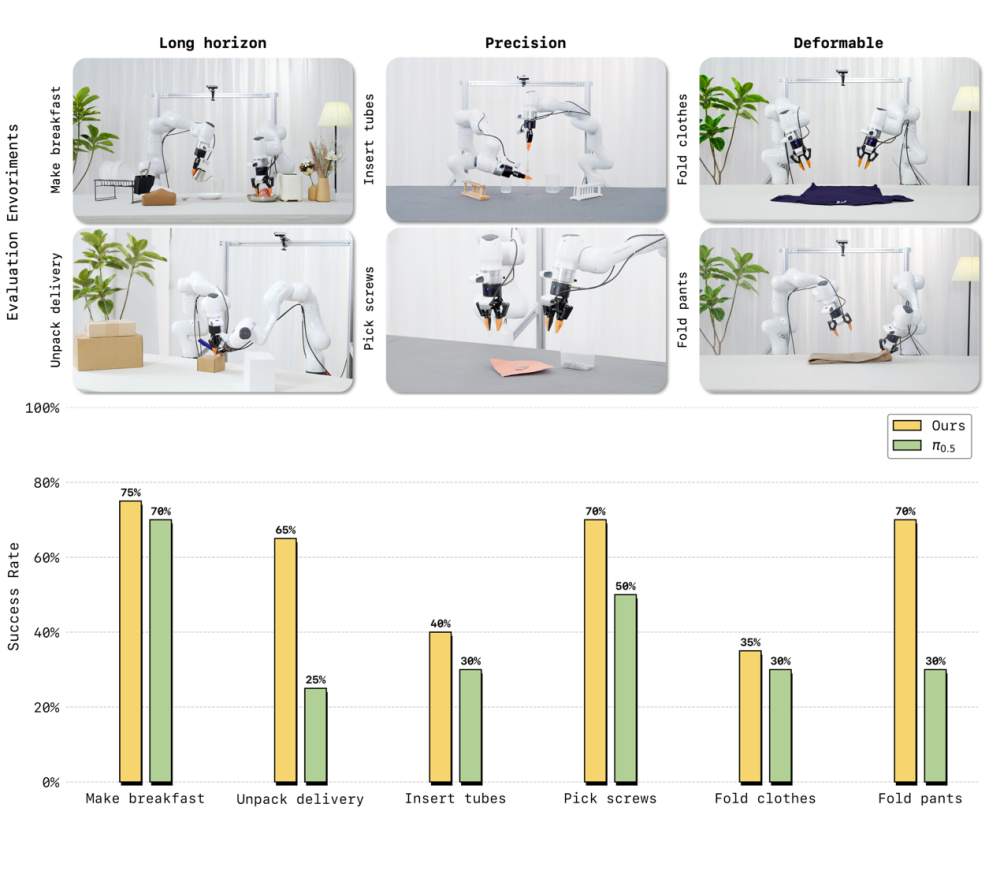

在真机评测中,LingBot-VA展现出对复杂物理交互的强适应能力。面对长时序任务(制作早餐、拾取螺丝)、高精度任务(插入试管、拆快递)以及柔性与关节物体操控(叠衣物、叠裤子)这三大类六项高难度挑战,仅需30~50条真机演示数据即可完成适配,且任务成功率相较业界强基线Pi0.5平均提升20%。

在仿真评测中,LingBot-VA在高难度双臂协同操作基准RoboTwin2.0上首次将成功率提升至超过90%,在长时序终身学习基准LIBERO上达到98.5%平均成功率,均刷新了行业纪录。

LingBot-VA采用Mixture-of-Transformers(MoT)架构,让视频处理与动作控制实现跨模态融合。通过独特的闭环推演机制,模型在每一步生成时都会纳入真实世界的实时反馈,确保持续生成的画面与动作不偏离物理现实,从而控制机器人完成高难复杂任务。

为突破大规模视频世界模型在机器人端侧落地的计算瓶颈,LingBot-VA设计了异步推理管线,将动作预测与电机执行并行化处理;同时引入基于记忆缓存的持久化机制与噪声历史增强策略,让推理时只需更少生成步骤即可输出稳定、精确的动作指令。这一系列优化使得LingBot-VA既拥有大模型的理解深度,又具备真机低延迟控制的响应速度,真正将世界模型带入了物理世界。

随着蚂蚁灵波科技系列连续发布三款具身领域大模型,蚂蚁的AGI战略实现了从数字世界到物理感知的关键延伸。这标志着其“基础模型-通用应用-实体交互”的全栈路径已然清晰。蚂蚁正通过InclusionAI社区将模型全部开源,和行业共建,探索AGI的边界。一个旨在深度融合开源开放并服务于真实场景的AGI生态,正加速成型。