编辑|Panda、杨文

临近春节,各家 AI 厂商进入冲刺阶段,纷纷亮出最新大模型成果。

1 月 15 日,美团也重磅更新自家模型 ——LongCat-Flash-Thinking-2601。

这是一款强大高效的大规模推理模型,拥有 5600 亿个参数,基于创新的 MoE 架构构建。

该模型引入了强大的重思考模式(Heavy Thinking Mode),能够同时启动 8 路思考并最终总结出一个更全面、更可靠的结论。目前重思考模式已在 LongCat AI 平台正式上线,人人均可体验。

仅选择「深度思考」时才会触发重思考模式。

体验链接:https://longcat.ai 模型地址:https://huggingface.co/meituan-longcat/LongCat-Flash-Thinking-2601 GitHub:https://github.com/meituan-longcat/LongCat-Flash-Thinking-2601不仅如此,该模型的智能体能力还获得了重大提升:在智能体工具调用、智能体搜索和工具集成推理等基准测试中达到顶尖性能,而且在任意的 OOD(分布外)真实智能体场景中实现了泛化能力的显著提升。

研究团队还专门提出了一种全新的智能体模型泛化能力评测方法。

通过构建自动化的环境和任务合成流程,基于给定关键词,随机生成任意的复杂任务。每个生成的任务都配备对应的工具集与可执行环境。

这种高度随机化的评测方式,能够更真实地检验模型在未知场景下的适应能力。

实验结果表明,LongCat-Flash-Thinking-2601 在该评测中始终保持领先性能。

接下来,我们就把模型拉到真实场景里实测一番。

一手实测:这只龙猫有点强

我们先来试试数理逻辑推理,顺便看看这个重思考模式到底是怎么一回事。

「运动会招募志愿者,第一次招募了不到 100 人,其中男女比例为 11:7;补招若干女性志愿者后,男女比例为 4:3。问最多可能补招了多少名女性志愿者?」

在 longcat.ai 上开启「深度思考」后,便进入了重思考模式,此时 8 个 Thinker 同时开工,每个都表现出不同的思考风格。有的按常规解题,有的则直接写了个 Python 脚本。

大部分 Thinker 给出了答案 5,其中 3 号和 6 号 Thinker 还写出详细的推导过程。待 8 个 Thinker 执行完任务后,模型再验证不同 Thinker 的思考过程,形成最终答案。

整个过程就像一个团队开会讨论问题,最后达成共识,最终给出的解答也更靠谱得多。

下面是道逻辑推理题。「A 的手机号码最后 5 位,由五个不同的数字组成。B 说:我猜它是 84261。C 说:我猜它是 26048。D 说:我猜它是 49280。A 说:巧了,你们每人都猜对了位置不相邻的两个数。你知道这五位号码是多少?」

8 个 Thinker 再次启动,各自从不同角度切入。

模型没有简单地按照「少数服从多数」的原则采纳意见,而是调用一段代码,系统验证答案是否满足所有约束条件,并穷举所有可能的组合,确认 86240 是唯一解。

这种将单个模型调用八次的模型编排方式,在技术实现上虽直接,却在实际效果上发挥出「三个臭皮匠顶过诸葛亮」的优势。

实测过程中,我们还发现了重思考模式的一种有趣玩法:投票。

举个例子,我们可以开启「深度思考」模式,然后让模型选出 2000 年代最优秀的华语流行歌手。

我们发现不同的 Thinker 会给出很不一样的答案,比如有一个仅选出了周杰伦、蔡依林、孙燕姿、王菲、陈奕迅五位代表,而另一个则直接列出了一长串名单。

最终,经过模型在总结阶段的汇总整理,LongCat-Flash-Thinking-2601 给出了一份涵盖多维度评估的名单,颇具参考性。

我们又试了下该模型的编程能力。先让它生成一个 Flappy Bird 小游戏,效果很不错。

Prompt:Make a game like flappy bird using HTML/CSS/JS in a single HTML file.

接下来我们又试了试让其编写一个康威生命游戏:

Prompt:用 Python 写一个 Conway 生命游戏,提供可视化网格、暂停、单步和参数调节功能。

但实事求是地说,使用 8 个 Thinker 来完成编程任务的计算成本应当是比较高的,可能并不适合大规模应用(尽管目前该模型对普通用户免费),但是我们认为这种模式却非常适合医疗、金融、法律等可能需要多次深度思考来保证准确性的场景。

最后,我们再来测试一下 LongCat-Flash-Thinking-2601 模型主打的 Agent 能力,其中的核心便是工具调用。

为了方便用户测试,美团专门构建了一个「大模型工具使用测试」平台。该平台能基于关键词随机生成复杂的 OOD(分布外)任务,专门用来试探模型在陌生环境下的行动能力。

我们随机生成了一个「营养补给方案」任务。平台生成了一个包含近30个工具的复杂图谱。从页面右侧的依赖关系可以看出,这并非简单的线性调用,模型需要像经验丰富的营养学家,理清儿童营养需求分析、食物营养成分计算、过敏食物筛选等工具之间环环相扣的逻辑。

更有趣的是,该平台还支持模型对比,让用户可以轻松地将 LongCat-Flash-Thinking 与其它模型放在同一起跑线上进行对比。

这里我们将其与当前大模型界的顶级选手 Claude 4.5 Opus 放在了同一个赛道上,进行同步竞技。

8 倍速视频

视频展示了两个模型在高频调用工具时的思考流。在任务完成后,系统会调用 AI 评估员,从执行速度与任务达成度两个维度进行复盘。

在这个具体案例中,两个模型都交出了高分答卷,但 LongCat 成功达到了 100% 的标准覆盖率,而 Claude 4.5 Opus 却未能成功为用户创建健康档案,仅达到了 80% 的覆盖率。整体而言,LongCat 在处理工具依赖关系的响应节奏上展现出了更强的稳定性。

深入细节,我们可以看到这些工具的调用和输出都采用了标准的 JSON 格式,这也是当前大量的 MCP 或 API 工具采用的主流格式。这也意味着,我们可以非常轻松地将 LongCat-Flash-Thinking-2601 整合进到现有的工作流程中。

强大实力的根基:重思考 + 智能体

那么,表现如此亮眼的 LongCat-Flash-Thinking-2601 究竟是如何炼成的?

正如其推文总结的那样,我们先给出几个关键词:并行思考、迭代式总结、环境规模扩展(Environment Scaling)、多环境大规模强化学习(Multi-Environment RL Scaling)、课程学习(Curriculum Learning)。另外,还有即将发布的 ZigZag Attention。

作为 LongCat-Flash-Thinking 的最新版本,2601 版本继承了上一版本的领域并行训练方案,而技术底座同样是参数总量达 560B 的高性能混合专家(MoE)架构模型。

来自 LongCat-Flash-Thinking 技术报告

在此基础上,如上文评测所示,除了一些细节上的优化,这个新版本重点引入了两大改进:重思考模式和智能体能力。

该模型新引入的重思考模式别具一格,我们目前还未见其它任何模型显式或开源地提供类似模式。

而在智能体能力方面,美团引入了一套精心设计的流程。该流程结合了环境规模扩展与后续任务合成,并会在此之上进行可靠且高效的大规模、多环境强化学习。为更好地适应真实世界智能体任务中固有的噪声与不确定性,美团 LongCat 团队还对多种类型和不同强度的环境噪声进行了系统分析,并采用课程式训练,使模型在非理想条件下依然保持稳健表现。

下面我们就来更具体地看看美团的这些核心技术。

重思考模式:推理广度与深度的协同扩展

打开 longcat.ai 「深度思考」后开始体验,你第一时间就会被同时冒出的 8 个 Thinker 吸引注意。这正是 LongCat 团队提出的 Heavy Thinking Mode(重思考模式)的外在表现。它不仅看起来炫酷,更重要的是将推理能力推向了新的边界。

大致来看,其与 AI 大牛 Andrej Karpathy 实验性的大模型议会项目有相似之处,但不同的是,Karpathy 的大模型议会是通过模型编排方式来向不同模型构成的集体提出问题,让它们各自发言并讨论后给出最终解答,而 LongCat-Flash-Thinking-2601 新引入的重思考模式则是并行地调用一个模型 8 次来实现高强度的并行思考。

如此一来,便可以同时获得多条相互独立的推理路径并进行交叉验证,从而显著降低偶然性错误,提升在复杂问题上的稳定性、可靠性与最终答案质量。如此一来,可以进一步提升模型在极具挑战性任务上的表现。

具体来说,该模式会将高难度问题求解分解为两个互补阶段:并行思考与总结,从而同时扩展推理的深度与宽度。

在推理宽度方面,重思考模式会并行生成多条独立轨迹,以广泛探索不同推理路径,并采用相对较高的推理温度以保证多样性。 在推理深度方面,总结阶段生成的精炼轨迹可以递归反馈给总结模型,形成支持逐步加深推理的迭代推理回路。LongCat 团队还专门设计了额外的强化学习阶段来训练总结能力,进一步释放该模式的潜力。智能体能力提升:环境规模扩展与多环境强化学习

智能体能力方面,LongCat 团队精心设计了一套自动化环境规模扩展链路,并构建了一组多样且高质量的环境,作为工具调用类任务强化学习的训练场,使模型能够习得高层次、可泛化的智能体能力。

每个环境包含多达 60 余种工具,并以高密度依赖图的形式组织,提供了足够的复杂度以支持多样化任务构建与大规模探索。实验表明,随着训练环境数量的增加,模型在分布外(OOD)任务中的表现会持续提升(Environment Scaling)。

高质量任务构建

为确保训练任务集的质量,LongCat 团队对任务复杂度和多样性进行显式控制。每个任务都定义在从高质量环境中采样得到的连通子图之上,任务复杂度通过要求在该子图内尽可能多地协同使用工具来调节。为促进任务多样性,已选工具的再次采样概率会逐步降低。

LongCat 团队还构建了配套数据库以确保任务的可执行性,并验证每个任务至少存在一种可执行解。然而,当环境中包含大量工具时,跨数据库的一致性维护会变得困难,可能导致部分任务无法验证。针对这一问题,LongCat 团队设计了专门的应对策略,使训练的稳定性和有效性得到了充分保障。

多环境强化学习

在保持高效异步训练和流式 rollout 特性的同时,LongCat 团队进一步扩展了其强化学习基础设施 DORA(异步弹性共卡系统),以支持环境规模扩展下的大规模多环境智能体训练(Multi-Environment RL Scaling)。

具体而言,来自多个环境的任务会在每个训练批次中以平衡的方式混合,并根据任务复杂度和当前训练状态分配不同的 rollout 预算。

下图展示了该模型的多环境混合强化学习训练曲线,可以看到上涨的趋势非常稳定,这表明美团构建的基础设施和算法可以有效保证训练的稳定性。

下图则展示了多环境强化学习训练下,模型在不同 OOD 测试集上的 RL Scaling 表现,效果非常明显。

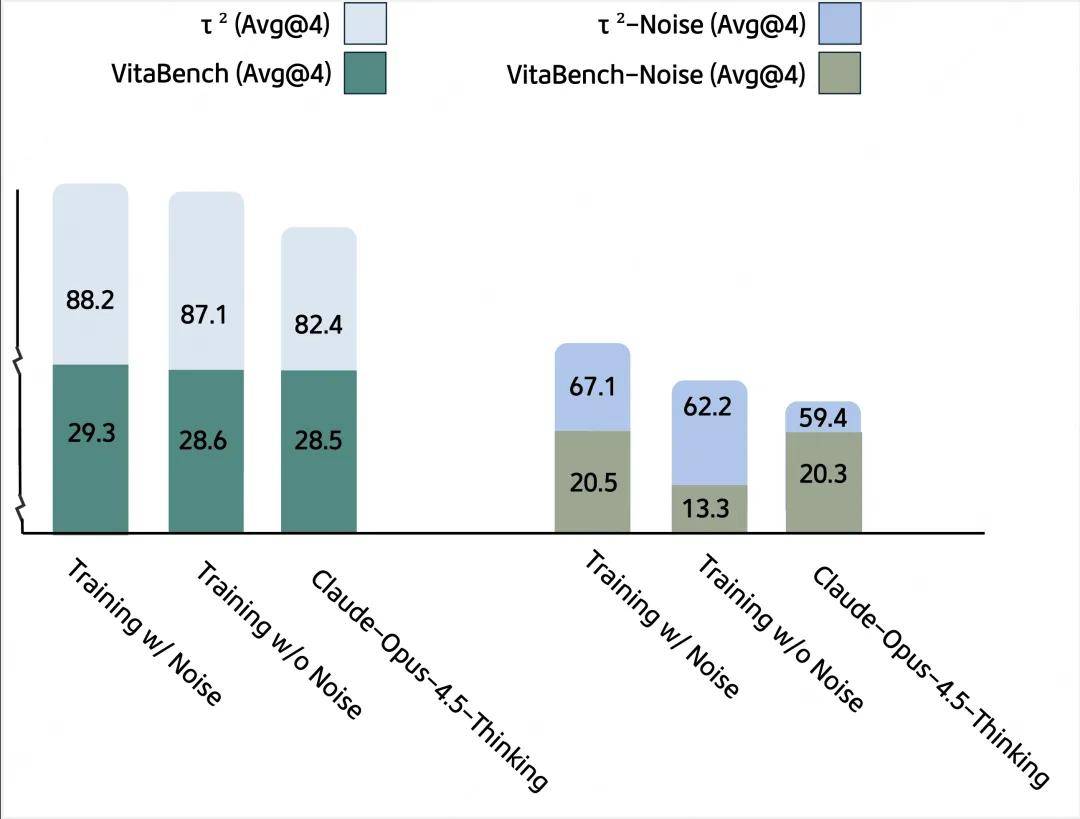

面向噪声环境的稳健训练

真实世界的智能体环境天然存在噪声和缺陷,仅在理想化环境中训练模型往往难以获得足够的稳健性。为此,LongCat 团队在训练过程中显式引入环境不完美因素,以提升模型的稳健性。

具体而言,LongCat 团队系统分析了智能体场景中真实世界噪声的主要来源,并设计了一套自动化流程,将这些噪声注入训练环境。在强化学习阶段,LongCat 团队采用课程式策略,随着训练推进逐步增加噪声的类型和强度。

下图展示了模型是否采取面向噪声环境的稳健训练,在带噪声 / 无噪声评测集下的表现对比,其中不同的评测集上依据特性添加了不同类型的噪声。可以看到,带噪声环境下未经过稳健训练的模型的表现会出现大幅衰减,Claude 也无法适应全部的噪声类型。而经过稳健训练后,LongCat-Flash-Thinking-2601(Training w/ Noise 组) 对环境的噪声和不确定性展现出了强大的适应能力,并在各类非理想条件下取得更优表现。

得益于这些改进与创新,LongCat-Flash-Thinking-2601 不仅在智能体工具使用、智能体搜索以及工具融合推理等基准测试中达到顶尖水平,还在任意的 OOD(分布外)真实世界智能体场景中展现出显著提升的泛化能力。

LongCat ZigZag Attention:实现超长上下文

LongCat ZigZag Attention,顾名思义,是一种注意力机制,根据其官方推文描述,其一大核心亮点是能「实现 100 万 token 上下文」。据悉,LongCat ZigZag Attention 已被成功用于训练当前 LongCat-Flash-Thinking 模型的一个分支,我们也将很快见证这个分支版本面世。细节详见论文:https://arxiv.org/abs/2512.23966

One More Thing

回头来看,美团大模型站到台前时间并不算长但节奏清晰,首次亮相在 2025 年 9 月,此后保持了每月一更的开源节奏,不断扩容自己的能力库:从强调响应速度的 LongCat-Flash-Chat 到专注逻辑的 Thinking 版本,再到图像和视频模型以及覆盖多模态的 Omni 版本,每一步迭代都在让这只龙猫能够更好地理解这个世界,并让复杂的现实生活变得更加可计算。

美团在 Hugging Face 上的论文页面

这一次,龙猫聚焦 Agent 与 Thinking 能力进行全面提升,也是实现了一次从理解到融入真实世界的跃迁。

或许,美团现在追求的,就是一种确定性:能够用技术在真实世界中又好又快地解决问题,终有一天让「模型即服务」。

文中视频链接:https://mp.weixin.qq.com/s/4CWGglF95Knyrc-ERzgI2w