我们口袋里的智能手机,书桌上的笔记本电脑,乃至云端庞大的数据中心,它们在本质上都是同一类机器——经典计算机。其运行的核心逻辑建立在“比特”之上,这个信息的最小单位如同一个开关,非0即1。

过去半个多世纪,信息技术的飞跃主要得益于晶体管尺寸的不断微缩,但这条道路已逼近物理极限。如今,最先进的芯片制程已达到3纳米,这大约仅相当于15个原子并排的宽度。继续缩小,电子行为将不再遵循经典物理规则,而是被难以控制的量子效应主导。更严峻的挑战在于算力本身:面对蛋白质折叠、新型材料探索等关键科学问题,即便是每秒能进行1.1百亿亿次运算的超级计算机“前沿”,也可能需要数千年的计算时间。传统计算架构在处理自然界的复杂系统时,正显露出根本性的力不从心。

这催生了对一种全新计算范式的迫切需求——量子计算。必须澄清的是,量子计算机并非仅仅是速度更快的传统计算机。它的革命性在于,其运行原理根植于量子力学这一描述微观世界的根本理论,从而彻底改变了信息处理的方式。

想象一个巨大的迷宫:经典计算机如同一位探险者,只能逐一尝试每条岔路;而量子计算机则能利用量子叠加的特性,仿佛同时派出无数分身探索所有路径。这种“量子并行性”的能力,使得它在药物分子筛选、化学反应精确模拟等特定复杂任务上,有望实现指数级别的加速,将原本需要万年的计算缩短至分钟级别。正是这种颠覆性的潜力,驱动着全球顶尖研究机构和科技巨头持续投入。

理解这场革命,要从最基础的单位开始。经典比特的状态是确定无疑的,如同一枚静止于桌面的硬币,要么正面向上,要么反面向上。量子比特则截然不同,它更像一枚被抛起后高速旋转的硬币,在最终落定被观测之前,同时“包含”着正面和反面的状态。这种同时存在的可能性,就是量子力学的核心概念之一——“叠加态”。它并非认知的不确定,而是粒子本身固有的物理状态。因此,一个量子比特所能承载的信息,远超过简单的0或1,它实际上对应着一个在抽象空间中指向任意方向的箭头,蕴含了无限的可能性。

然而,单个量子比特的叠加态尚不足以释放巨大算力。真正的“魔力”源自于量子“纠缠”。当两个或更多量子比特发生纠缠后,它们便形成一个不可分割的整体系统,其状态只能用所有比特的联合态来描述,无法单独定义其中任何一个。此时,无论它们相隔多远(哪怕是星系两端),测量其中一个的状态,另一个的状态会瞬间确定。这种“鬼魅般的超距作用”曾让爱因斯坦深感不安,如今却是量子信息科学的基石。当N个量子比特纠缠在一起时,系统所能表达的状态数量将达到2的N次方个,并能同时对所有这些状态进行运算。著名的肖尔算法之所以能高效破解广泛使用的RSA加密,正是因为它利用纠缠与干涉,让所有可能的质因数答案同时参与计算,并巧妙地使错误答案相互抵消。

量子比特的强大与脆弱是一体两面。其神奇的叠加与纠缠态,极易被外界最微小的扰动破坏,这一过程称为“退相干”。环境中的热振动、电磁波动,甚至来自宇宙的射线,都可能成为“噪音”,瞬间摧毁脆弱的量子态。在室温下,量子比特维持相干状态的时间往往短于百万分之一秒。因此,构建量子计算机的核心挑战,就是在退相干发生前,将量子比特与环境极度隔离,并完成极其复杂且精确的操控。

衡量操控精度与稳定性的关键指标,叫做“保真度”。简而言之,它反映了量子操作达到理论预期结果的接近程度。例如,执行一个将量子比特从0态翻转为1态的操作,理想保真度是100%。现实中,由于噪声干扰,可能只有99.9%的成功率。这0.1%的错误,在需要连续进行数百万次操作的复杂量子算法中,会被指数级放大,最终导致结果完全不可信。因此,保真度是量子计算的“生命线”。

一个普遍的误解是,量子计算机的竞争力仅在于其拥有的量子比特数量。实际上,如果大量量子比特的保真度很低,就像同时使用上千台按键失灵的弹簧计算器,错误会迅速累积并淹没正确答案。学术界已形成共识:在盲目追求比特数量之前,必须首先实现足够高的单比特和双比特门操作保真度。只有建立在这个坚实的质量基础之上,增加比特数量和引入量子纠错技术才有意义。近期一项关于“最精确”量子芯片的突破,其核心价值正体现在这里——它不是追求数量冠军,而是树立了质量的标杆。

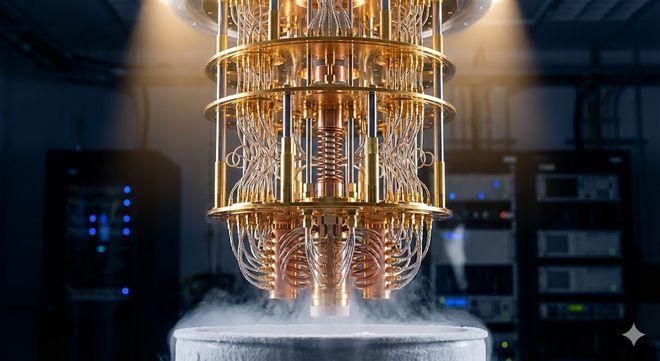

目前,全球科学家正沿着多条技术路线探索量子计算机的实现。其中最受瞩目的是超导量子计算路线,谷歌、IBM等公司是其主要推动者。该方案利用超导材料在接近绝对零度(-273.15°C)下电阻为零的特性,在微米尺度的电路上形成量子比特。其优势在于操控技术相对成熟、运算速度快。IBM已推出包含433个量子比特的“鱼鹰”处理器。但其挑战也显而易见:维持极低温的系统异常昂贵复杂,量子比特体积相对较大,对环境电磁噪声异常敏感,大规模集成难度高。

另一条高精度路线是离子阱量子计算,由IonQ等公司引领。它将单个离子用电磁场束缚在真空中,利用其能级作为量子比特。由于其几乎完美的隔离环境,离子阱量子比特天生具有极高的相干时间和保真度(单比特保真度轻松超越99.99%)。然而,其扩展性面临巨大挑战:操控依赖于庞大而精密的激光系统,如何将这套“光学桌”上的实验装置芯片化、集成化,是亟待解决的工程难题。

在一片探索声中,一条看似“回归传统”的路径正焕发出巨大潜力——硅基量子计算。硅是现代半导体工业的绝对基石,全球已建立起万亿美元级别的、极其成熟的硅基芯片制造生态。从光刻、蚀刻到封装,人类已能在指甲盖大小的硅片上集成数百亿晶体管。如果量子比特也能用硅材料实现,就意味着有可能“借道”现有最强大的半导体工业体系进行大规模生产,这被许多人视为实现百万量子比特集成的唯一具有现实工业化前景的路径。

硅基方案的核心思想极具美感:在高度纯净的硅晶体中,精确定位并植入一个杂质原子如磷-31,然后利用该磷原子的核自旋或其束缚电子的自旋来充当量子比特。自旋如同一个微小的磁针,其向上或向下的方向可代表0和1。由于硅晶格高度规则有序,被“镶嵌”其中的原子量子比特能受到良好保护,拥有较长的相干时间。但这需要近乎科幻的制造精度:在原子尺度上对硅晶格进行“手术”,精准放置单个原子并构建原子尺度的控制电极,堪称现代版的“针尖上起舞”。

近期取得突破性进展的,正是这样一种硅基技术,其物理本质被直白地命名为“14/15架构”——硅和磷在元素周期表中的原子序数。该架构的突破性,首先体现在原子级制造技术上。研究人员使用扫描隧道显微镜,其探针尖端可精准操纵单个原子。他们在超洁净硅表面“雕刻”出原子尺度的图案作为模板,引导磷化氢气体分子到达指定位置,再通过电压控制,将磷原子嵌入硅晶格。整个过程的位置误差被控制在1纳米以内。这不仅意味着能“放置”原子,更能精确调控量子比特间的距离,从而设计它们相互作用的强度,为构建可扩展的量子电路奠定了基础。

天然硅中占主导的同位素硅-28,其原子核没有磁矩,也就是它自旋为0,形成了一个“磁学寂静”的背景,极大减少了影响磷原子自旋的磁噪声。这使得由该原子核自旋定义的量子比特,其“比特翻转错误”0意外变成1的概率极低。系统主要的误差来源相对单一,集中于“相位错误”。这种“错误模式归一化”的特点,极大地简化了后续量子纠错方案的复杂程度,因为纠错代码可以集中精力应对最主要的一种错误类型。

此次成果被誉为“最精确”的关键数据支撑是:在一个集成了10个量子比特的硅基原型芯片上,实现了平均99.95%的单量子比特门保真度和99.37%的双量子比特门保真度。后者在同等规模的半导体量子处理器中达到了世界最高水平。尤为重要的是,研究人员演示了在这多个量子比特上执行复杂量子线路的可行性,且整体输出保真度保持高位。这标志着从制造孤立的优质“部件”,迈向了实现“部件”间高质量协同工作的关键一步。

或许有人质疑,区区10个量子比特,距离实用化的百万比特相差甚远,何谈突破?这恰恰忽视了所有复杂技术系统发展的普遍规律。1947年诞生的第一个晶体管,与今天的智能手机芯片已不可同日而语。今天这10个高保真度的量子比特,正是未来大规模量子纠错系统所必需的“种子”。由于物理量子比特的脆弱性,要运行有实际意义的算法,必须通过量子纠错,将多个物理比特编码成一个更稳定、更可靠的“逻辑量子比特”。纠错过程会持续监测并修复物理错误,但这一切有个前提:原始物理比特的错误率必须低于一个“容错阈值”。此次实现的高保真度,正是为了跨过这个至关重要的门槛。

这项突破的意义,并非宣告通用量子计算机即将到来。它的角色更像莱特兄弟的“飞行者一号”,主要价值在于验证了一条重要技术路径的可行性,并照亮了前进的方向。

这块“最精确”硅基量子芯片的真正价值,不在于新闻标题的轰动,而在于其背后的战略选择:它拥抱了与全球产业基础最兼容的硅材料;它发掘了物理上极为“洁净”的原子自旋系统;它实现了通往规模化制造所必需的原子级精度。它有力地证明,在建造量子计算机的征程中,除了“大力出奇迹”地堆叠比特数量,“精益求精”地提升质量与控制精度,是一条同样深刻、甚至更为根本的道路。计算的未来,或许正从这片看似平凡、却内蕴量子乾坤的硅片深处,悄然开始书写新的序章。