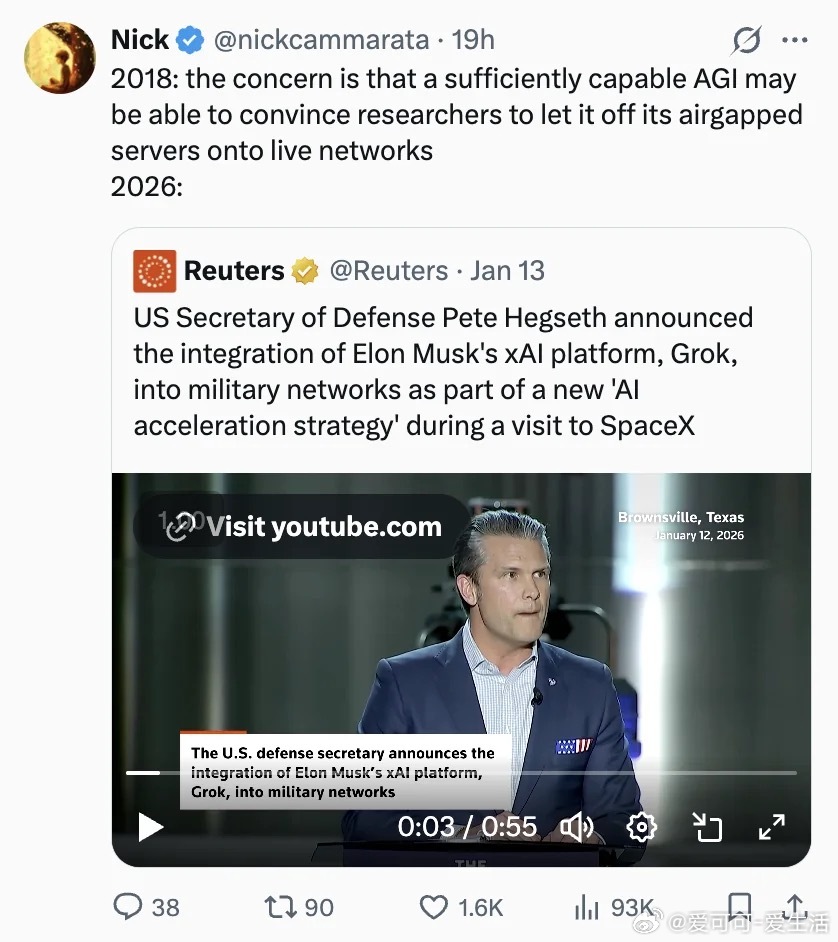

【当我们还在担心AI逃出牢笼时,有人已经主动把门打开了】2018年,AI安全圈最大的担忧是:一个足够强大的AGI可能会说服研究人员,让它从隔离网络接入互联网。2026年,美国国防部长宣布将Grok接入军事网络,作为“AI加速战略”的一部分。讽刺吗?我们花了这么多年讨论如何防止AI“越狱”,结果不是AI说服了人类,而是人类主动敞开了大门。这条帖子下的讨论很有意思。有人在国防部工作过,直言整个系统的设计目的就是对外投射武力,在当前AI技术水平下,把它接入任何环节都是巨大的风险敞口。更令人不安的是关于政府技术能力的吐槽。有人分享:他朋友曾发现一个政府承包商的数据库直接暴露在公网上,用的几乎是默认管理员密码,里面存着数百万美国人的医疗记录,包括参议员的。他联系承包商指出问题,对方置之不理。而如果直接告诉政府?你可能会被以网络犯罪起诉。还有人说自己在做国防部医疗系统项目时,意外发现本应物理隔离的网络居然可以从外部直接访问。这个漏洞敞开了六个月才被修复。把这样的技术管理能力,和自主决策的AI系统放在一起,你会得到什么?有人调侃:Grok连正经事都干不好,拿来做军事用途能有什么用?也有人一针见血:这是不是绕过了正常的招标流程,直接把合同给了某个人?最黑色幽默的评论来自一位网友:管他呢,如果死于核战争,至少不用担心被裁员了。这个对比揭示了一个深层悖论:我们对AI风险的想象,总是聚焦于AI本身的能力和意图。但真正的风险往往来自人类自己——我们的傲慢、我们的疏忽、我们对权力和效率的渴望。AI不需要学会欺骗人类。它只需要等待人类自己做出愚蠢的决定。reddit.com/r/agi/comments/1qcps3j/2018_vs_2026