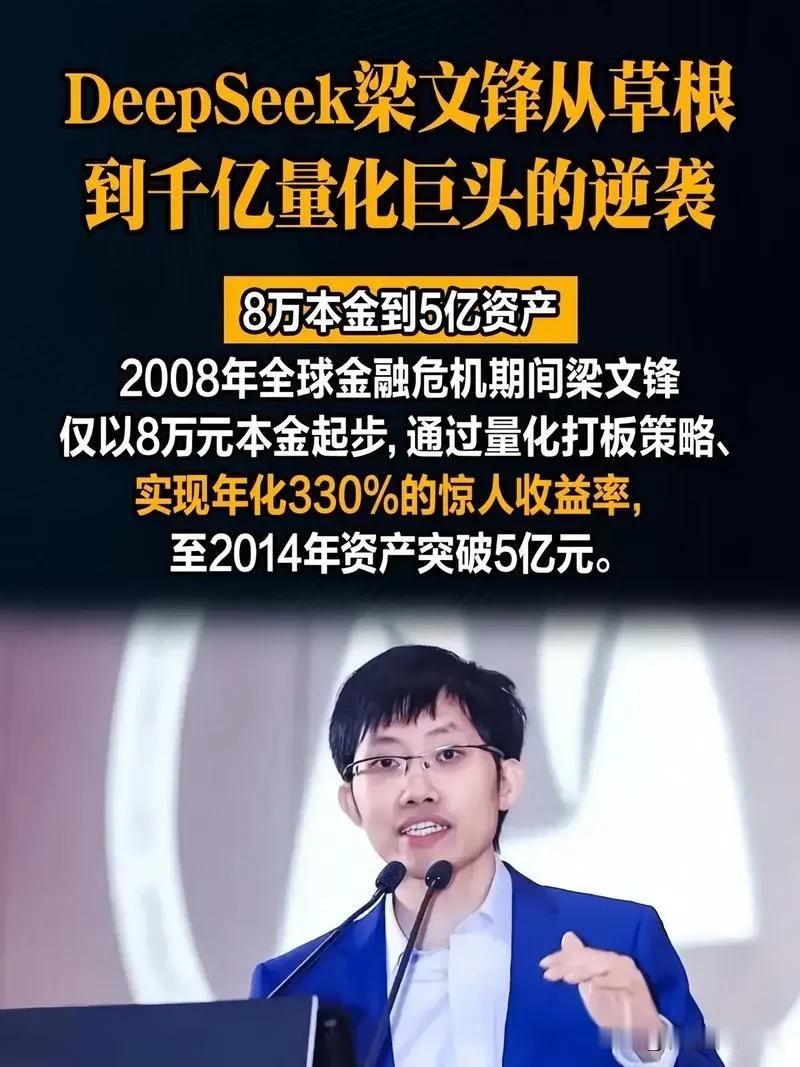

一个管着上千亿资金的量化大佬,梁文锋,突然在内部会上,对着帮他赚钱的整个团队,扔下一句话。 他说,别跟我提什么中国AI跟美国只差一两年,那都是表面功夫,是我们永远在追,人家永远在前面领。 这话从手握千亿资金、亲身布局AGI的梁文锋口中说出,分量远超普通议论。 作为幻方量化与DeepSeek的双重创始人,他见过AI产业最光鲜的估值神话,也深知底层创新的残酷真相——当市场沉浸在“200多个国产大模型百花齐放”的狂欢中,当专利数量、论文总量连续多年位居全球第一的数据刷屏时,核心技术的话语权仍牢牢掌握在他人手中。 这种差距不是简单的参数比拼,而是从底层架构到生态构建的系统性落差。 国产AI的“表面繁荣”早已埋下隐患。 2024年行业数据显示,大模型相关企业融资额占AI领域总投资的73%,基础研究机构获得的资金占比却不足5%。资本疯狂追逐能快速变现的应用层优化,却对需要长期投入的底层技术避之不及。 高校科研评价机制中,技术转化指标分值高达40%,倒逼实验室将理论成果强行包装成“产业解决方案”,真正的原创理论研究反而被边缘化。 这种短视导向下,国内AI顶会论文中原创理论占比从2018年的28%降至2024年的11%,五年内没有重大理论突破通过国家科技奖初审。 技术路径依赖正在加剧这种被动。国内AI芯片设计企业90%采用ARM架构授权,核心指令集自主率仅为8%;不少国产大模型的底层算子仍高度依赖国外加速库,导致每瓦特算力成本比国际竞品高出40%。 即便像DeepSeek这样实现性能比肩GPT-4o的企业,仍要面临高端芯片获取受限的困境。这种“硬件靠授权、框架靠借鉴、算法靠优化”的模式,注定只能在别人划定的赛道里追赶,难以形成真正的技术壁垒。 梁文锋的清醒,源于他亲身践行的创新之路。为了摆脱依赖,他带领团队砸下十亿建设“萤火二号”超级计算机,自主研发原生稀疏注意力等核心技术,让DeepSeek-V3以4000万元的训练成本实现了国际顶尖性能,这种成本控制能力背后是实打实的架构创新。 更难得的是,他选择将模型权重与训练技术全部开源,打破了技术封闭的壁垒,这种魄力正是当下AI产业最稀缺的原创精神。但这样的案例太少,多数企业仍停留在“拿来主义”的舒适区,在别人的技术框架上做修修补补,就宣称实现了“弯道超车”。 人才结构的失衡进一步拉大差距。2024年AI应届毕业生中,82%选择了高薪的算法优化岗位,仅6%愿意投身基础理论研究。 认知科学研究员岗位平均薪资比算法工程师低58%,这种巨大的收入差距,让年轻人不愿沉下心来做长期探索。高校为迎合市场需求,甚至取消了哲学与人工智能交叉学科招生计划,导致基础研究人才断层,而没有人才支撑的原创,终究只是空谈。 值得欣慰的是,改变正在发生。广东研发投入连续九年领跑全国,2024年应用研究经费同比激增64.6%,研发活动开始向创新链条前端拓展。政策层面,“东数西算”工程优化算力资源配置,“揭榜挂帅”机制集中力量攻关核心技术。 以DeepSeek为代表的企业突破Transformer架构专利壁垒,在混合专家模型、稀疏注意力等领域实现原创突破,让国产大模型首次具备了全球话语权。这些变化证明,原创并非遥不可及,关键在于能否摆脱短期利益的束缚。 AI产业的竞争从来不是百米冲刺,而是一场需要耐心与坚守的马拉松。表面的参数追赶容易,底层的原创突破艰难;模仿能赚快钱,却换不来真正的技术主权。 梁文锋的话,是对全行业的警醒——只有打破路径依赖,把资源真正投向基础研究与核心技术,让人才愿意深耕、企业敢于投入、政策持续护航,才能从“跟跑者”真正变成“引领者”。 科技竞争的核心是原创力的较量,这不仅关乎企业的生死存亡,更关乎国家的科技主权与产业安全。当更多企业像梁文锋那样,愿意放下短期利益,投身硬核创新的深水区,中国AI才能真正摆脱“模仿”的标签,在全球科技竞争中占据主动。 各位读者你们怎么看?欢迎在评论区讨论。