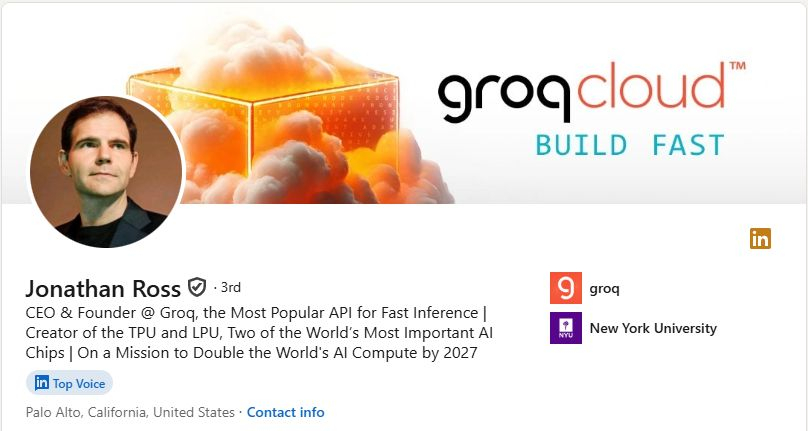

Groq早在9年前创办,但为何这一两年才忽然被广泛讨论,成为「Nvidia杀手」?到被Nvidia重金「收购」?2016 年,当 TPU之父Jonathan Ross 离开 Google 创立 Groq 时,他给自己的新发明取了一个看似狂妄的名字:LPU (Language Processing Unit,语言处理单元)。在当时,这简直是营销上的自杀。那一年,AI 的主流战场是图像识别(ImageNet),而不是语言。大语言模型(LLM)的概念还处于婴儿期,将芯片命名为「语言处理单元」,就像在汽车刚发明时,宣称自己造了一架「飞机」一样,既超前又令人困惑。Groq做了一个在当时看来极其冒险的硬件决策:抛弃 HBM(高带宽内存),全押 SRAM(静态随机存取内存)。这是一个关于「容量」与「速度」的终极取舍。▋Nvidia的选择 (HBM)这就像是一辆巨大的货车。它能装载海量的货物(数据),一次可以运送 80GB 甚至更多的模型权重。但它的缺点是,货车装卸货很慢,而且仓库(内存)离工厂(计算核心)有一段距离,数据传输存在物理瓶颈。▋Groq 的选择 (SRAM): 这就像是一辆法拉利跑车。它的后备箱非常小(单个芯片只有 230MB 容量),装不了多少东西。但它的速度快得惊人。Groq 将 SRAM 直接铺在计算核心旁边,数据传输速度达到了惊人的 80TB/s——这是Nvidia HBM 速度的 10 倍以上。这就是 LPU 速度神话的物理基础。在 LPU 上,数据不需要在仓库和工厂之间来回奔波,它就在手边。然而,这也是 Groq 早期最大的软肋。因为 SRAM 非常昂贵且占空间,单颗 LPU 无法装下任何现代的大型 AI 模型。要运行一个大模型,你需要将数百颗 LPU 连接在一起,让它们像一个巨型大脑一样协同工作。在 2016 年到 2022 年间,这被视为一种极其不经济的架构。「为什么我要买 500 颗芯片来跑一个模型,而Nvidia的一颗芯片就能装下?」这是当时投资人和客户最常问的问题。▋孤独的先知在 ChatGPT 爆发之前的岁月里,Groq 是一个孤独的异类。当时的 AI 市场由「训练」主导。训练需要的是吞吐量(Throughput),是让货车一次拉最多的货。Nvidia的 GPU 是为此而生的王者。而 Groq 专注的是「推理」的延迟(Latency),也就是法拉利送货的速度。那时,没有人需要法拉利。大家都在做脱机的数据分析,晚上把数据丢进去,第二天早上看结果,快一秒慢一秒根本没人在乎。在这段时间中,根本没人关心推理。投资人看不懂为什么要追求极致的低延迟,客户也不在乎 0.2 秒和 1 秒的区别。Groq 曾数次濒临破产,Ross 甚至不得不自掏腰包维持公司运转。Jonathan Ross 和他的团队在没有掌声的舞台上坚持了八年。他们被嘲笑为「偏科生」,被质疑技术路线走进了死胡同。他们制造了一把屠龙刀,却发现世界上只有杀鸡的需求。直到 2022 年底,OpenAI 发布了 ChatGPT。一夜之间,世界变了。AI 不再是后台的批处理任务,变成了前台的实时对话。用户开始在乎每一个字的生成速度。延迟成为了新的痛点。Groq 等待的风,终于来了。这家「离经叛道」的公司,终于迎来它命运的转折点。而这笔交易的重要性,当然不止于此。我在圣诞节赶工了一整天,写好了篇Nvidia「收购」Groq的深入分析,看完全文后,你会对这笔交易的战略价值有不同的理解。这篇万多字的深入分析将会限时免费48小时,有兴趣的朋友,到我Substack订阅我的电子报,就可以阅读完整分析。- KP