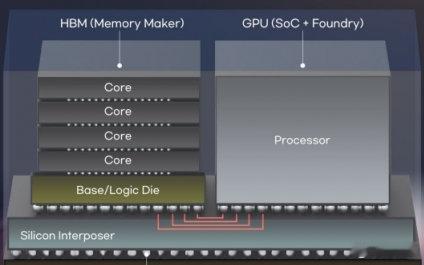

GPU与HBM之间的界限正在崩塌……下一代HBM将嵌入GPU核心一种在下一代高带宽内存(HBM)上安装图形处理单元(GPU)的方法正在被积极研发。这是全球科技巨头为提升人工智能(AI)性能而尝试的一项新技术,标志着在存储与系统半导体融合的背景下,半导体行业之间的传统边界正在被打破。据26日综合报道,Meta和英伟达(NVIDIA)正在评估将GPU核心集成到HBM中的计划。具体而言,是将GPU核心嵌入HBM堆栈底部的基芯片(base die)中,目前他们正在与SK海力士和三星电子探讨合作。多位熟悉该行业的内部人士表示:“我们正在讨论下一代‘定制HBM’架构,其中一种方案就是将GPU核心直接集成到HBM的基芯片中。”HBM是一种通过堆叠多个DRAM芯片而成的高性能内存,专为需要处理大量数据的AI应用而设计。目前,基芯片位于HBM结构的最底层,负责内存与外部之间的通信。在此基础上,HBM4进一步引入了“控制器”功能。行业正尝试通过加入可控制内存的半导体来提升性能与效率。HBM4预计将于明年开始大规模量产。将GPU核心嵌入HBM被视为比HBM4控制器更先进的技术。在GPU和CPU中,核心是独立计算的基本单元。例如,一个4核GPU意味着有四个可计算的核心;核心越多,计算性能越强。将核心集成进HBM的尝试,旨在将原本集中在GPU中的计算功能分散到内存中,从而减少数据传输量,减轻主GPU的负担。一位业内人士表示:“在AI计算中,重要的不仅是速度,还有能效。”他补充道,“缩短内存与计算单元之间的物理距离,可以同时降低数据传输延迟和功耗。”然而,这一技术仍面临挑战。由于硅通孔(TSV)工艺的特性,HBM基芯片中可用于容纳GPU核心的空间非常有限。供电与散热也是关键问题。GPU计算核心功耗高、发热大,热控制可能成为瓶颈。这一发展对国内半导体产业而言既是机遇也是危机。如果企业具备实现CPU或GPU的代工或封装能力,就有机会进一步开发HBM,继续引领AI半导体市场。但如果应对能力不足,可能会沦为系统半导体行业的附庸。韩国KAIST电气工程系教授Kim Joung-ho表示:“随着AI发展推动存储与系统半导体之间的边界消失,技术转型的速度将进一步加快。”他补充道,“国内企业必须将生态系统从存储扩展到逻辑领域,以抢占下一代HBM市场。”