物理界也有GPT了科学家训练出通用物理模型

科学家正在尝试打造一个“通用物理模型”(像GPT一样的基础模型),但用来模拟现实世界的物理系统。他们做出的原型叫GPhyT,可以看作是物理界的预训练大模型。

它的目标不是精通某一种特定物理任务,而是能“看懂”各种力学系统的泛化能力,不用因为换了问题就重训一遍。

简单说下它怎么做的:

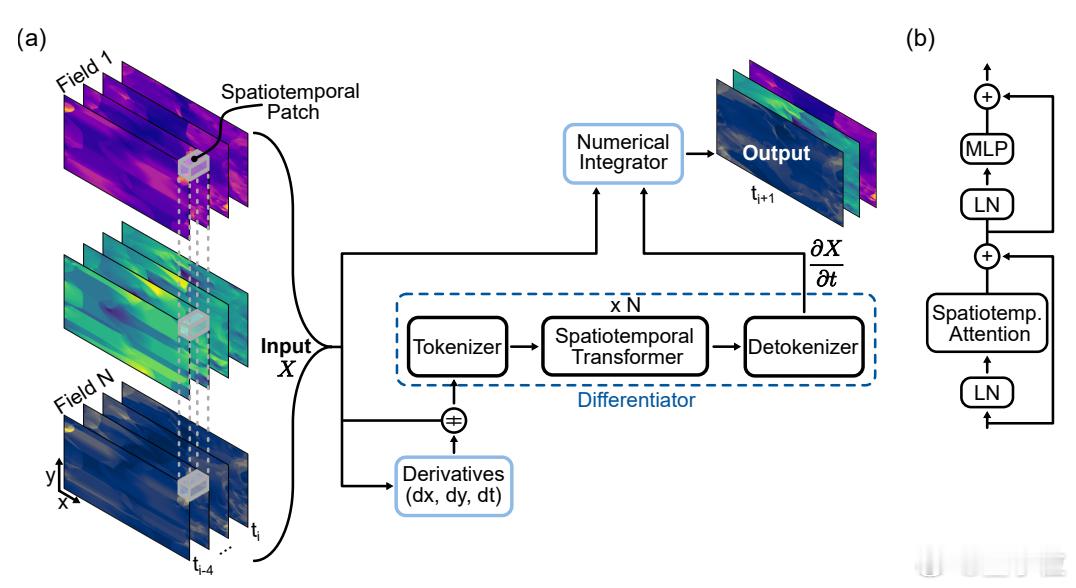

- 模型核心叫“神经微分器”,输入一段时间序列,比如速度、温度、压力,预测下一刻的状态变化;

- 使用时空统一建模的Transformer,能处理像涡流、冲击波这样时空耦合强的现象;

- 最后用数值积分(欧拉法)把预测的时间变化转成未来状态。

模拟数据这块,训练就用了1.8TB,涵盖各种类型:

- 流体力学(比如不可压缩流、热对流)

- 多相流(比如液体遇到固体障碍物)

- 热传导(比如热量在不同物质间的交换)

为了让GPT-style的模型能“悟性好”,团队还做了一些泛化设计:

- 在不同时间间隔上训练,逼模型学会“自己推时间单位”;

- 不同数据用不同方式归一化,防止模型记数据而不是物理规律。

效果方面,对比试验里,GPhyT比两个强模型FNO和UNet表现都更好,平均误差分别降了5倍和29倍。

零样本泛化能力:比如训练时从来没见过“超音速绕障流”,但只看环境数据,GPhyT就能模拟出弓形激波——这和语言模型遇新题能答题有异曲同工之妙。

模型还能做长时间推演,例如连续预测了50个时间步,在一些混沌系统上(像剪切流、多相流)略有误差,但大结构还是稳的。

不过它还远称不上完美。当前GPhyT只在2D平面上工作,未来需要扩展到3D;不少经典物理学科,比如力学或化学还没覆盖;长时间模拟还容易累计误差;而且它适应不了现实中多变的网格分辨率。

整体来看,这是机器学习冲进物理领域的一次野心尝试:想用一个足够通用的神经网络,把写了几十年的物理方程统统打包。

它离替代一切物理仿真器还有些距离,但也确实向通用物理引擎迈了一步。

感兴趣的小伙伴可以点击:github.com/FloWsnr/General-Physics-Transformer