汽车算力真相数值背后,藏着“能用多少”的“鸡贼”

内行看门道,外行看热闹,这些天有炒作的所谓 Thor 算力问题,在行业内其实被大家当成乐子来看。

你听见的的“XXXX TOPS算力”,可能就像网购平台的起售价标价——等你把各种优惠卷折扣算进去,真实算力才会原形毕露

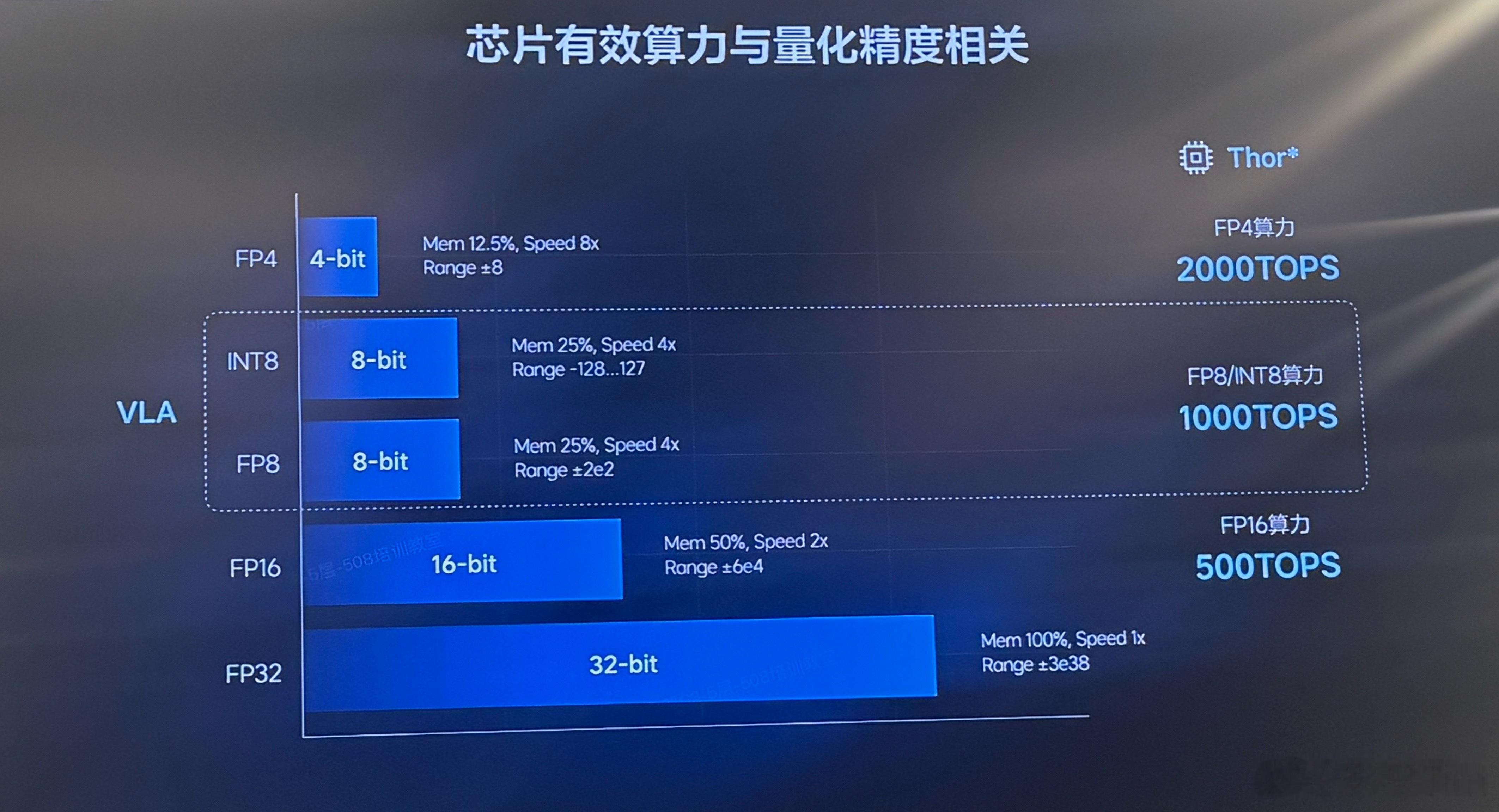

NVIDIA 的Thor芯片,4位浮点数(FP4)下的性能甚至高达 2000TOPS;若用(比如FP32)模型,实际能用的可能只剩300 TOPS。

前几天Nvidia发了一篇文章,介绍了Thor算力的情况。DRIVE AGX Thor SoC 支持 4 位浮点数(FP4)和 8 位浮点数(FP8),可提供前所未有的 2,000 FP4 TOPS/1,000 INT8 TOPS/1,000 FP8 TFLOPS/500 FP16 TFLOPS 性能。

离开剂量谈毒性就是耍流氓,离开模型精度谈算力也是如此。如果你说你的模型非得用FP32,那thor的算力确实连300tops都没有。

影总认为算力数值得绑着模型精度看,理想的VLA模型采用的是INT8和FP8的混合推理精度,对应的是1000TOPS 的量级。(没有别家不是这个精度的意思,没有拉踩的意图,纯叙述)

同时研发团队还在将精度逐渐往INT4去优化,从而“压榨”芯片获取更大的算力。但这也非常考验工程能力,不是每个人都能做到的。

目前理想ADmax团队能把2B模型部署到OrinX上,就是将FP32做到了INT4量化+FP16推理来实现的。

说到底,真实的用户其实不关心Thor算力到底有多少TOPS(小黑子才在乎),只在乎语音指令反应快不快、智驾决策准不准。算力是燃料,模型利用率是发动机——数值再高,烧不起来也是白搭。

希望用大白话能够把算力的问题和大家科普清楚,不要被别有用心的人带了节奏

影总聊智驾