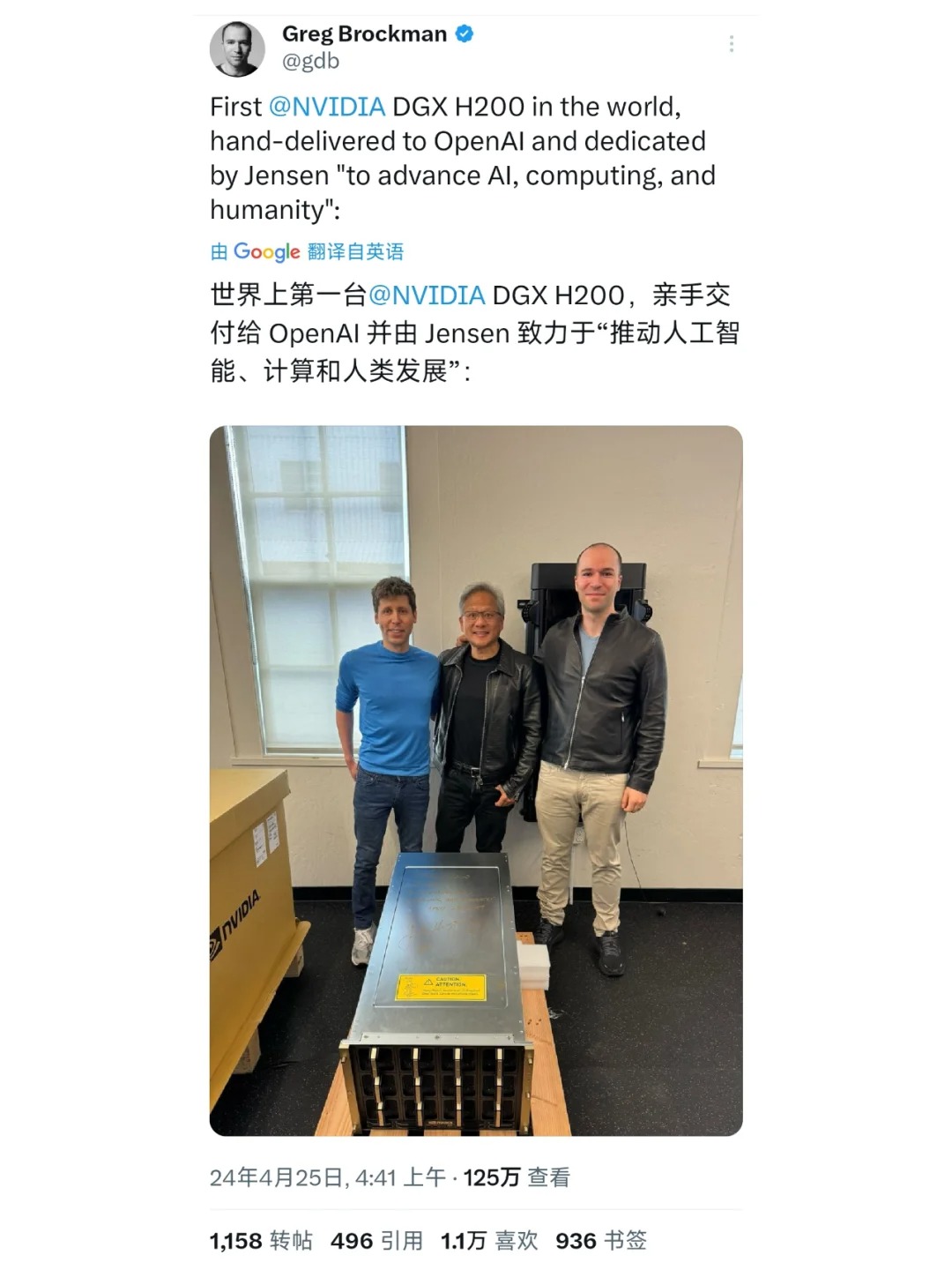

H200显卡交付,国内大模型公司面临算力困境 💻NVIDIA创始人黄仁勋亲手将全球首块DGX H200显卡交付给OpenAI,这块显卡拥有高达19.5TB的总GPU内存,相当于250块80GB显卡的性能,为OpenAI训练更大规模、更强大的语言模型提供了重要的算力保障。

🤖反观国内,诸多致力于开发大模型的公司难以获得如此顶尖的AI硬件。这可能导致他们在算力上与拥有最新硬件的竞争对手存在算力差距。

⚙️再对比meta的几十万张显卡存量,而国内能拿出万卡训练大语言模型的又有几家?

🔍面对"算力鸿沟",国内大模型公司将如何应对?

评论列表