每张图像都有光学指纹点扩散函数建模方法

你知道吗?图像里其实藏着一种“隐形信息”,这是它独属于自己的“光学指纹”。

这些指纹,在悄悄透露拍摄设备的信息。现在,我们有办法把这个隐藏的光学指纹提取出来。

斯坦福和Google的研究团队提出了一种新方法,叫Lens Blur Fields(镜头模糊场),它能快速学习一台设备的光学模糊特征,换句话说:

通过分析模糊,就能识别设备、修复图像,甚至重建真实的景深效果。

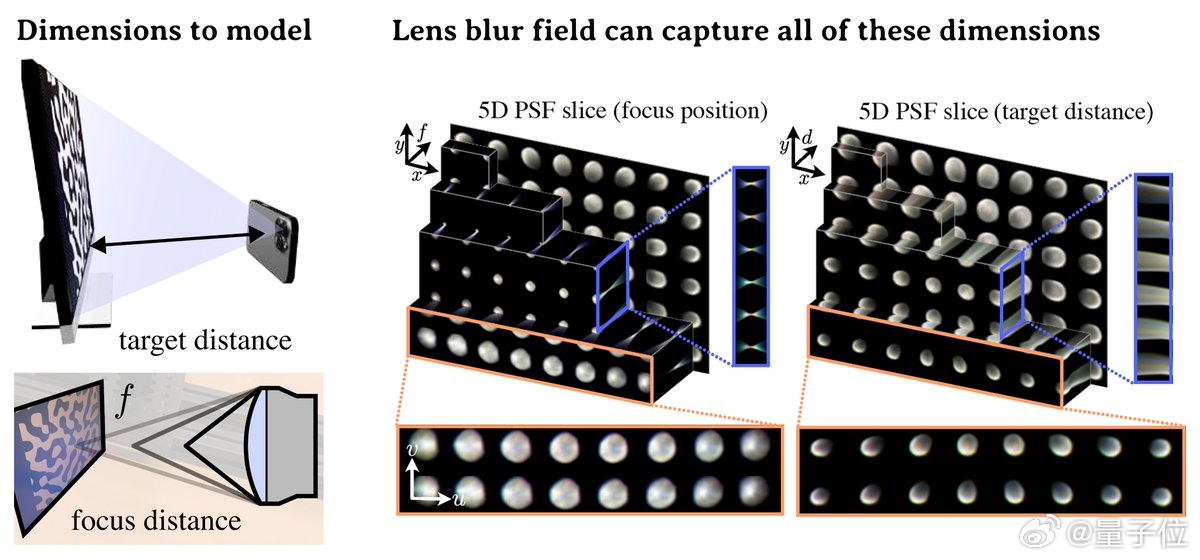

这项研究的核心点在于建模PSF(Point Spread Function,点扩散函数)——它描述了一个理想点光源经过镜头系统后在图像中被“模糊成什么样”。现实中,PSF会因为各种原因发生变化:

- 焦距不同、镜头对焦位置不同

- 画面中位置不同(中心、边缘模糊程度不一样)

- 镜头制造差异、微小的装配偏差等等

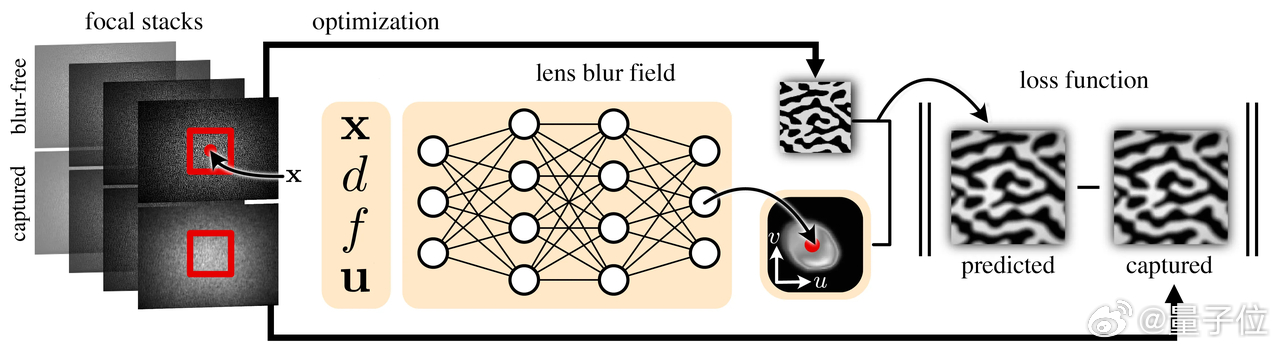

而这套方法用一个小型神经网络(MLP)来拟合这个复杂、高维度的模糊变化,过程如下:

- 采集方式:只需要一台显示器 + 手机支架,拍几组不同焦段的屏幕图案;

- 训练过程:通过非盲去卷积反推PSF,几分钟就能出结果;

- 最终输出一个连续的、设备特定的PSF模型,这就是所谓的Lens Blur Field。

这个模型能做什么?

- 设备识别:即使是同一型号的手机(比如两台iPhone 12 Pro),模糊指纹也能精确区分;

- 图像修复:用“知道是谁拍的”这个前提,来更好地还原图像细节;

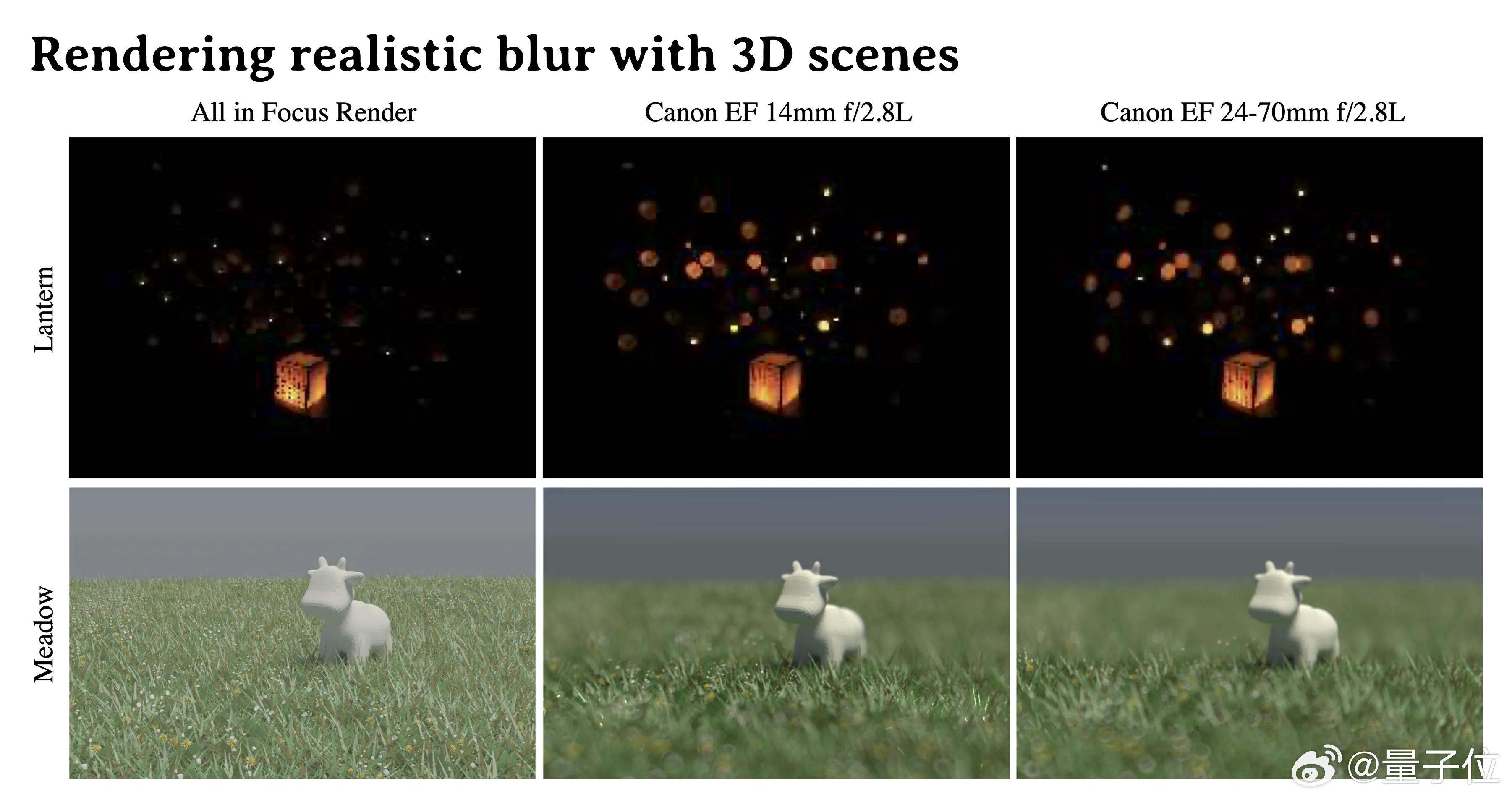

- 真实渲染:在合成景深、渲染3D场景时,生成符合该镜头真实特性的模糊效果;

- 数据分析/法医图像:识别图像拍摄设备、检测图像篡改等。

团队还会公开首个5D/6D模糊场数据集,覆盖智能手机和单反镜头,让设备级图像建模变得标准化。

感兴趣的小伙伴可以点击:blur-fields.github.io