随着 iPhone 发布临近,我们可以预测一下 A 系列芯片会重点升级对 LLM 的支持。

A17 Pro 已经支持了 Transformer 相关算子,而隔壁 Google G5 更加激进,所以苹果肯定要寻求扳回一局。

在模型能力越来越强的时代,苹果手里的护城河还剩下四个:

1

本地加速算力(A 系列芯片)+本地模型

低延迟,完全免费,有很强的不可替代性。

2

基于用户隐私数据的提示词优化

用户积累的数据可以用于提示词优化,同样的模型,用户隐私数据积累越多的设备,表现可能会更好。

也有一定的不可替代性。

3

iOS 系统权限

为云端模型 or 本地开放 iOS 更多的系统权限,模型表现也可能更好。

不过这方面 Google 很可能会比苹果更激进。

4

更便宜的 token 价格

目前开发者调用 Apple Intelligence ,苹果好像是完全不收费的。而一旦大量的任务可以在端侧通过小模型完成,基本上苹果设备上的推理,可以认为是免费的。

大量消耗 token 的绝大多数简单的基础任务,开发者不会再去 open ai 买 token 了。

但是一个不可回避的问题是:

iOS 和 LLM ,未来谁才是中心?

在没有权限控制的 web 上,答案已经清晰,就是所有的网络 apps 提供 mcp ,模型访问并且运用。

模型才是中心。

而你是不可能期待苹果云端模型的核心能力,可以媲美 Open AI 的吧?所以,对苹果而言,iOS or iPhone 必须是中心。

Apple Intelligence 实际上是期待整个生态的模型访问,都通过苹果。(用更多的系统权限,更好的用户隐私数据支持,更便宜的 token 价格,更快的本地加速算力支持来换取 Apps 开发者生态的支持)

苹果能如愿以偿吗?

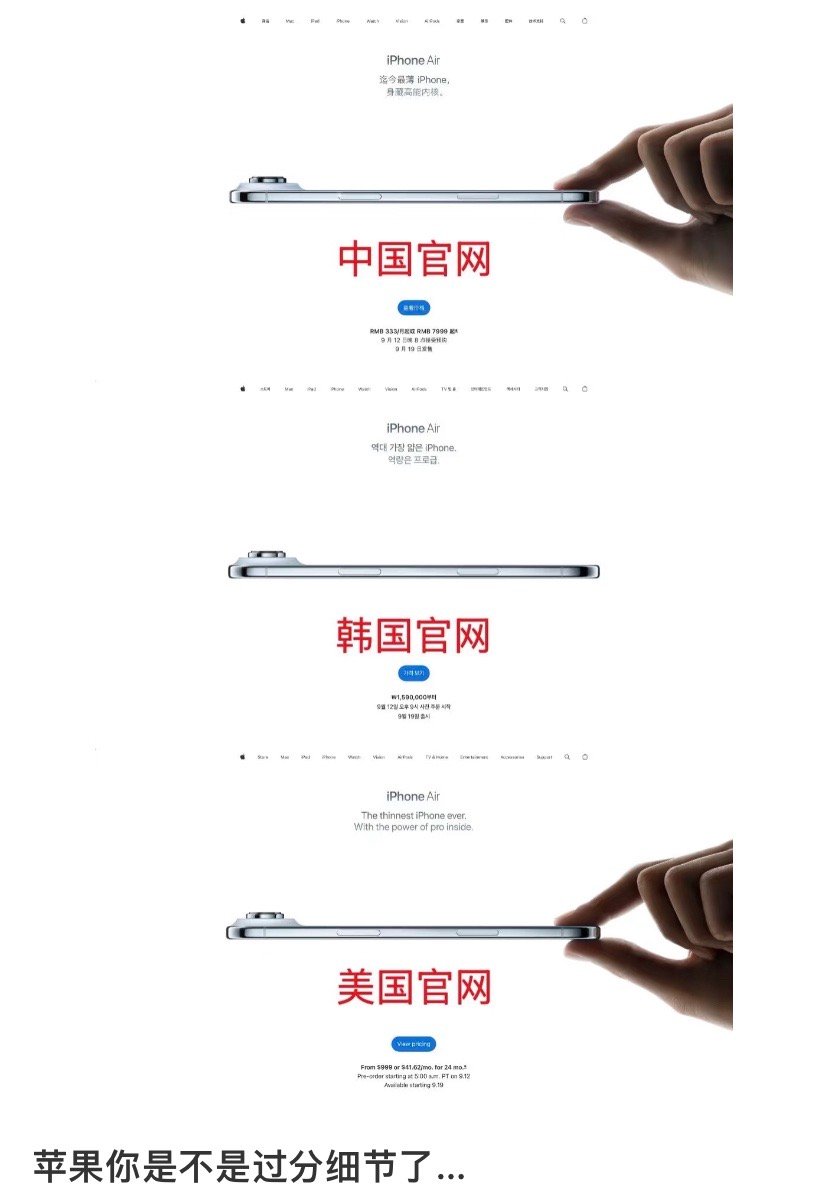

![iPhone17系列价格笑得我不行,这是谁做的图……?[笑着哭]](http://image.uczzd.cn/8750365958507413898.jpg?id=0)