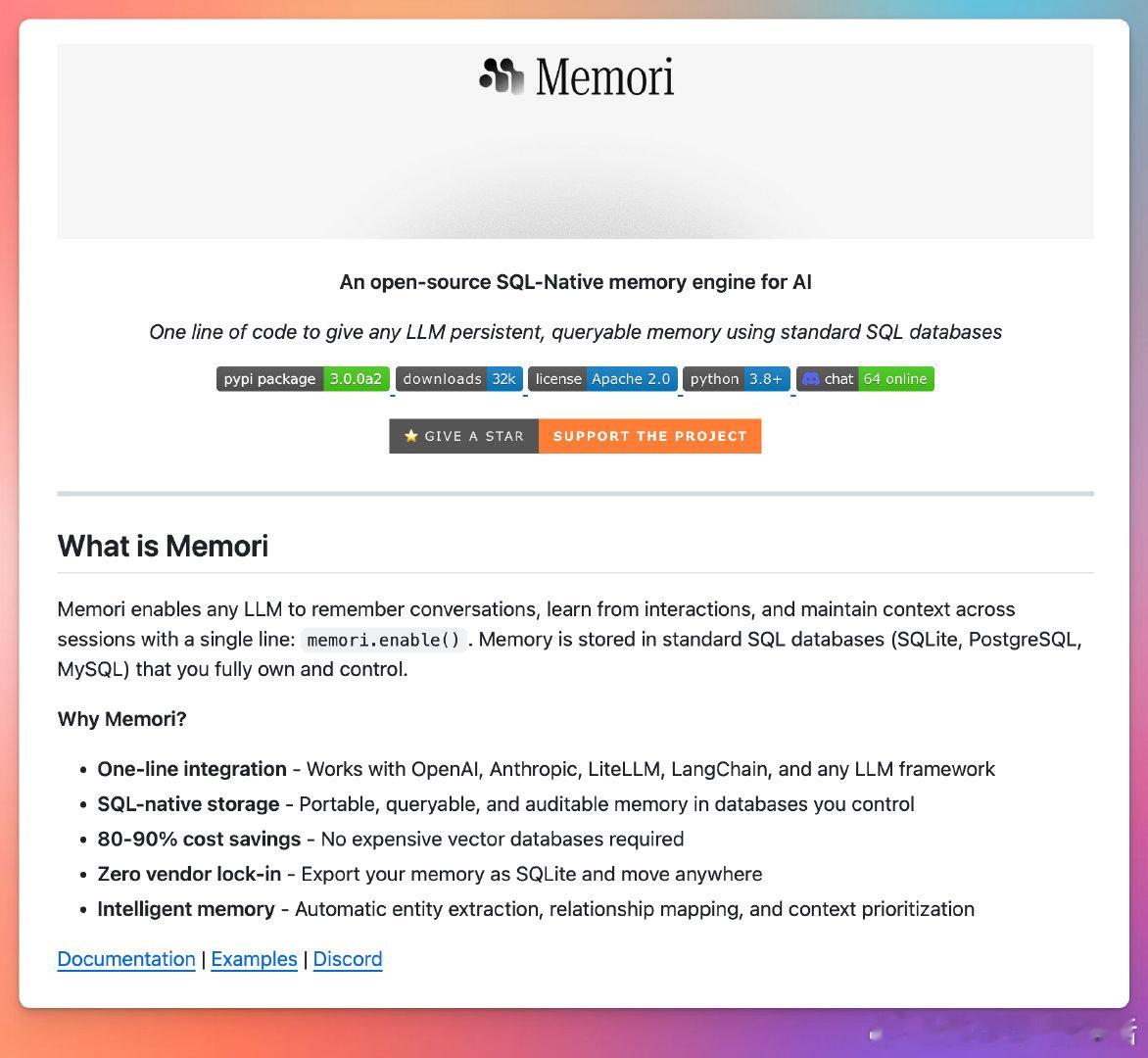

如何用一行代码,帮你节省60%到80%的Token消耗?答案是给大语言模型(LLM)“装上记忆”。引入Memori——一个开源、轻量级的记忆层,只需一句代码`memori.enable()`,即可让你的模型拥有短期和长期记忆,提升上下文理解和响应准确性,极大降低调用成本。以GPT-5为例:- 每100万Token费用从11.25美元降到2.25美元- 每1000万Token费用从112.5美元降到22.5美元这不仅仅是省钱,更是效率和体验的飞跃。Memori支持任意数据库(SQLite、PostgreSQL、MySQL等),完美适配各种应用和多代理系统架构,确保数据完全由你掌控。它的设计思路,是用部分关键上下文+摘要替代全量聊天记录,极大减少重复Token消耗。用户反馈也证实: “没用记忆,基本等于重复付费”“记忆让回答更连贯稳定,不用每次重头解释”“一行代码让模型变得更聪明,也更省钱”。技术角度看,给模型加记忆就像给它装上“脑袋”,它开始真正记住你的需求,减少无效对话,成本直线下降。这不是简单的缓存或摘要,而是更智能的上下文管理和数据归纳,未来AI应用的成本控制和体验优化关键。想要用更少的Token,获得更多价值,Memori是值得尝试的利器。详细代码和资料在这里:github.com/GibsonAI/memori——记忆赋能大语言模型,不只是省钱,更是让AI真正理解你,让对话持续进步。技术创新带来的不是微小改进,而是架构级变革,拥抱智能记忆,就是拥抱未来AI的高效与可能。